嗨喽!大家好呀,这里是Python/ target=_blank class=infotextkey>Python茜吖~

一个帮助用户表达自我,记录的视频平台。●记录美好、智能匹配音乐、一键卡点视频,超多原创、滤镜、场景切换帮你...

今天我们就来用Python 采集无水印视频内容

1. win + R 输入 cmd 点击确定, 输入安装命令 pip install 模块名 (pip install requests) 回车

2. 在pycharm中点击Terminal(终端) 输入安装命令

失败一: pip 不是内部命令

解决方法: 设置环境变量

失败二: 出现大量报红 (read time out)

解决方法: 因为是网络链接超时, 需要切换镜像源

清华:

https://pypi.tuna.tsinghua.edu.cn/simple

阿里云:

https://mirrors.aliyun.com/pypi/simple/

中国科技大学

https://pypi.mirrors.ustc.edu.cn/simple/

华中理工大学:

https://pypi.hustunique.com/

山东理工大学:

https://pypi.sdutlinux.org/

豆瓣:

https://pypi.douban.com/simple/

例如:pip3 install -i

https://pypi.doubanio.com/simple/ 模块名

失败三: cmd里面显示已经安装过了, 或者安装成功了, 但是在pycharm里面还是无法导入

解决方法: 可能安装了多个python版本 (anaconda 或者 python 安装一个即可) 卸载一个就好

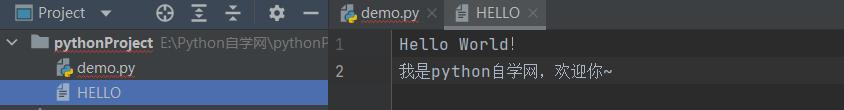

或者你pycharm里面python解释器没有设置好

选择file(文件) >>> setting(设置) >>> Project(项目) >>> python interpreter(python解释器)点击齿轮, 选择add添加python安装路径

选择file(文件) >>> setting(设置) >>> Plugins(插件)点击 Marketplace 输入想要安装的插件名字 比如:翻译插件 输入 translation / 汉化插件 输入 Chinese选择相应的插件点击 install(安装) 即可安装成功之后 是会弹出 重启pycharm的选项 点击确定, 重启即可生效

一. 数据来源分析确定爬取的内容是什么?

爬取抖音视频内容通过开发者工具进行抓包分析 F12 或者 鼠标右键点击插件选�.NETwork

I. 通过分析已经找到播放地址

II. 去分析, 播放地址可以从什么获取

对于视频播放url地址 进行一次转码 *** >>> 等会提取的时候 需要进行解码

二. 代码实现步骤

过程发送请求, 用python代码模拟浏览器去发送请求

获取数据, 获取服务器返回响应数据

解析数据, 提取视频url地址 以及 视频标题

保存数据, 保存数据到本地

# 导入数据请求模块

import requests # pip install requests win + R 输入cmd

# 导入正则

import re # 内置模块 不需要大家去安装

import time # 时间模块

from selenium import webdriver # pip install selenium==3.141.0

def drop_down():

"""执行页面滚动的操作""" # JAVAscript

for x in range(1, 30, 4): # 1 3 5 7 9 在你不断的下拉过程中, 页面高度也会变的

time.sleep(1)

j = x / 9 # 1/9 3/9 5/9 9/9

# document.documentElement.scrollTop 指定滚动条的位置

# document.documentElement.scrollHeight 获取浏览器页面的最大高度

js = 'document.documentElement.scrollTop = document.documentElement.scrollHeight * %f' % j

driver.execute_script(js)

# 人怎么去操作浏览器的, 就怎么写代码...

# 1. 打开一个浏览器或者下载一个浏览器吧 创建浏览器对象(实例化一个浏览器对象)

driver = webdriver.Chrome()

# 2. 输入一个网址 请求网址

driver.get('https://www.douyin.com/user/MS4wLjABAAAA4N4OrZzTSmCPp8vVAqCeyU215Kav2JgFv2Lfy4DNWRs')

driver.implicitly_wait(10)

# 3. 提取所有li标签 返回列表

# drop_down()

lis = driver.find_elements_by_css_selector('.ECMy_Zdt')

for li in lis:

html_url = li.find_element_by_css_selector('a').get_attribute('href')

print(html_url)

# 1. 发送请求, 用python代码模拟浏览器去发送请求

# url = 'https://www.douyin.com/video/7066324040335592738'

# headers 作用 伪装python代码 伪装成浏览器 user-agent: 用户代理 浏览器基本身份标识 cookie 用于检测用户信息, 是否有登陆账号

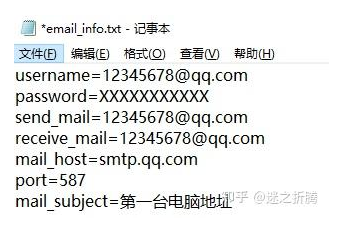

headers = {

'cookie': 'douyin.com; ttcid=444dfe8e89ff4d99b0662076ad171c8775; ttwid=1%7CTnFKlrGi3lHjKf5bshFdP9Nwu_Vsiwo-TxvX9NISgj8%7C1642083887%7Cfbfa904ea2900763eb6ac090bdd09014d80840da1ca485bbfea193d5401b330e; MONITOR_WEB_ID=6d75c626-96a0-4270-ac18-aa0090b5bdb8; MONITOR_DEVICE_ID=341246a2-17c2-4c11-9c70-3ffd2cda0ffa; MONITOR_WEB_ID=c27b9f4a-4917-4256-be93-e948308467e3; odin_tt=0510c3c4196f54b541a96ac64e8b585b3a755be85057da8a1f3fa068e3f7b75ca2de4345e2b856f1e7b3f9455d86079731fe7d07a9f10890f26855d3674858e1; _tea_utm_cache_6383=undefined; douyin.com; strategyABtestKey=1648291293.035; passport_csrf_token=e0b90cb756903c370592bd558c2b0cf5; passport_csrf_token_default=e0b90cb756903c370592bd558c2b0cf5; AB_LOGIN_GUIDE_TIMESTAMP=1648291292963; s_v_web_id=verify_l17q2u00_kNENOykG_BIPh_4VLs_AVDZ_yMj0GtFSNH1u; _tea_utm_cache_1300=undefined; _tea_utm_cache_2285=undefined; THEME_STAY_TIME=299042; IS_HIDE_THEME_CHANGE=1; msToken=5X5W_7rY6cmo_SaaiMyCREV1hCZs-Jd9b7whX5GNCZsd9FU0zCTWYYAl0VhqGGUCjKS3bQf0f191VXdWHPNgqUz08MHEhk6qWhu4wVOlxhLyh3Vliaw37NU=; __ac_nonce=0623f02e00009007ea9bb; __ac_signature=_02B4Z6wo00f010eZ3RAAAIDCJJMde2RciUNHvdmAALPkmrPh1wY1Ey-OtTubjdK69ub9bqUt9DNRx8aP7dPtbOjyxcxyyK6yToF.7c4e615hiM5fYGwFCq0x8jHiY7BYLt6JZLIH8y38eMikd9; home_can_add_dy_2_desktop=1; msToken=fSBhJysNLifNHon5sgM-8n_3ZzJD49mCn9GUHLQydo7g52tCvrhNEKMFhxKEKlAxdE-z7er6yxwoJyO7-C_RdyslJnPejx9AAnkluZ22tSxM4siS7FUuO8E=; tt_scid=T-Exmos8oZiW6Wkb0uEjKsqAdjzxSnn4nznfku9EUmnDmpgq6Me7VDpIiYW4Fv805451; pwa_guide_count=3',

'user-agent': 'Mozilla/5.0 (windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/99.0.4844.82 Safari/537.36'

}

response = requests.get(url=html_url, headers=headers) # <Response [200]> 表示的是响应对象 200状态码 请求成功

# 2. 获取数据

# print(response.text) # 获取html字符串数据 服务器返回response响应文本数据

# 3. 解析数据

# findall 找到所有, 从什么哪里去找什么数据 正则匹配出来数据返回都是列表数据 [] 列表 [0] 取第一个元素

title = re.findall('<title data-react-helmet="true">(.*?) - 抖音</title>', response.text)[0]

video_url = re.findall('src(.*?)vr%3D%2', response.text)[0]

# print(video_url)

video_url = requests.utils.unquote(video_url).replace('":"', 'https:') # 解码 并且使用replace字符串替换

# print(title)

# print(video_url)

# 4. 保存数据 视频数据内容

video_content = requests.get(url=video_url, headers=headers).content # 对于视频播放地址发送请求,获取二进制数据内容

with open('video\' + title + '.mp4', mode='wb') as f:

f.write(video_content)

print(title, '保存完成')

python采集抖音孙一宁所发小视频~简单爬虫小案例_哔哩哔哩_bilibili

好了,我的这篇文章写到这里就结束啦!

有更多建议或问题可以评论区或私信我哦!一起加油努力叭(ง •_•)ง

喜欢就关注一下博主,或点赞收藏评论一下我的文章叭!!!