翻译自——EEtimes

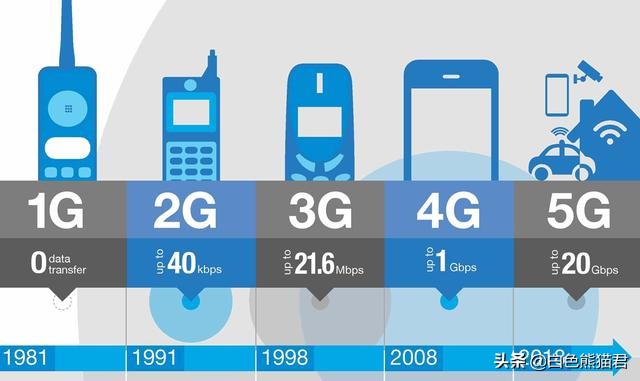

近期,一种用光子张量处理器代替GPU来进行机器学习的神经网络计算的新方法表明,在处理光学数据传输的性能上可以提高2-3阶。这也表明光子处理器具有增强电子系统的潜力,并可能在5G网络边缘设备中表现强劲。

美国乔治华盛顿大学电子和计算机工程系的Mario Miscuglio和Volker Sorger在《应用物理评论杂志》上发表了一篇论文,题为《基于光子的处理单元使更复杂的机器学习成为可能》。

在他们的方法中,光子张量核并行执行矩阵乘法,这提高了深度学习的速度和效率。在机器学习中,神经网络被训练来学习如何在不可见的数据上执行无监督的决策和分类任务。一旦神经网络对数据进行了训练,它就可以产生一种推断,从而对对象和模式进行识别和分类,并在数据中找到一个特征。

光子TPU并行存储和处理数据,具有电光互连的特点,可以有效地读写光存储器,并与其他架构进行接口。

作者之一Mario Miscuglio表示:“我们发现集成了高效光存储的集成光子平台可以获得与张量处理单元相同的操作,但它们只消耗一小部分的功率,并具有更高的吞吐量,如果经过适当的训练,可以用于以光速进行推理。”

大多数神经网络旨在模仿人类大脑的多层相互连接的神经元。表示这些网络的一种有效方法是将矩阵和向量相乘的复合函数。这种表示方式允许通过专门用于向量化操作(如矩阵乘法)的架构来执行并行操作。

(a)光子张量核(PTC)由一个16点积引擎组成,内在独立地逐列逐行逐点乘法和累加。点积引擎执行两个向量之间的乘法。输入矩阵的第i行由由高速(如马赫-曾德尔)调制器调制的波分复用信号给出。通过适当设置核矩阵的权值状态,将核矩阵的第j列加载到光子存储器中。利用光-物质与相变存储器的相互作用,利用微环谐振器(MRR)对输入信号进行频谱滤波,并采用看似量子化的电吸收方案进行加权。(例如调幅),从而执行按元素进行的乘法。使用光检测器将元素式乘法非相干求和,这相当于mac操作(Dij)。

任务越智能化,预测精度就越高,网络就越复杂。这样的网络需要更大的计算量和更大的处理能力。当前适合于深度学习的数字处理器,如图形处理单元(GPU)或张量处理单元(TPU),由于所需的功率以及处理器和存储器之间电子数据的缓慢传输,在执行更复杂、更精确的操作方面受到了限制。

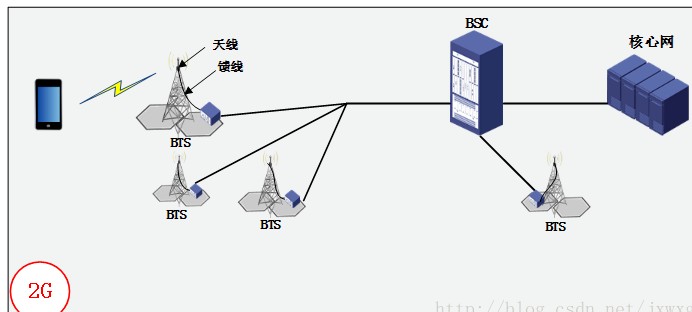

研究人员表明,他们的TPU性能可以比电子TPU高出2-3个数量级。对于计算节点分布式网络和在网络边缘(如5G)执行高吞吐量智能任务的引擎来说,光子可能是一个理想的匹配。在网络边缘,数据信号可能已经以来自监控摄像机、光学传感器和其他来源的光子的形式存在。

Miscuglio:“光子专用处理器可以节省大量的能源,提高响应时间并减少数据中心的流量。”对于终端用户来说,这意味着处理数据的速度要快得多,因为数据的很大一部分是预处理的,这意味着只需要将其余部分数据发送到云或数据中心。

光与电的较量

本文给出了利用光路完成机器学习任务的实例。在大多数神经网络(NNs)中,每一个神经元和每一层,以及网络的互连,都是训练网络的关键。根据训练,在其连通层中,神经网络强烈依赖于向量矩阵的数学运算,其中输入数据和权重的大矩阵根据训练相乘。复杂的、多层的深层神经网络需要大量的带宽和低延迟,以满足执行大矩阵乘法所需的大量操作,而不牺牲效率和速度。

那么如何有效地将这些矩阵相乘呢?对于通用处理器,矩阵操作在需要连续访问缓存内存的情况下串行进行,从而产生冯·诺依曼瓶颈[1]。而GPU和TPU等特殊的架构,有助于减少这些冯·诺依曼瓶颈的影响,使一些有效的机器学习模型成为可能。

与CPU相比,GPU和TPU意义重大,但是当用它们来实现深度神经网络对大型2维数据集(如图像)执行推断时,可能会耗电,并且需要更长的计算运行时间(大于几十毫秒)。对于不那么复杂的推理任务来说,更小的矩阵乘法仍然受到不可忽略的延迟挑战,主要是由于各种内存层次的访问开销和GPU中执行每条指令的延迟。

作者建议,在这种情况下,有必要探索和重新研发当前逻辑计算平台的操作范式,在这种逻辑计算平台中,矩阵代数依赖于对内存的连续访问。在这方面,光的波动性质和相关的固有操作,如干涉和衍射,可以在提高计算吞吐量和同时降低神经形态平台的功耗方面发挥重要作用。

他们建议未来的技术应该在其随时间变化的输入信号所在的领域执行计算任务,并利用其内在的物理操作。在这个观点中,光子是计算节点分布式网络和在网络边缘(如5G)对大数据执行智能任务的引擎的理想匹配,其中数据信号可能已经以光子的形式存在(如监控摄像头、光学传感器等),从而预先过滤和智能调节允许向下游流向数据中心和云系统的数据流量。

在这里,他们探索了利用光子张量核(PTC)的方法,该方法能够与训练好的核进行一次性的4乘4矩阵的(非迭代的)和完全被动的乘法和积累。换句话说,一旦NN被训练,权重被存储在一个4位的多层光子存储器中,直接在芯片上实现,而不需要额外的电光电路或芯片外DRAM。该光子存储器具有低损耗、相变、纳米光子电路的特点,其基础是将G2Sb2Se5的导线沉积在一个平面波导上,可以使用电热开关进行更新,并且可以完全通过光学读取。电热开关是由夹住相变存储器(PCM)导线的钨加热电极实现。

作者表示,这项工作代表了实现并行存储数据和处理的光子张量处理器的第一种方法,与提供实时分析的最先进的硬件加速器相比,它可以将相乘累积(MAC)操作的数量提高几个数量级,同时显著降低功耗和延迟。

与依赖逻辑门的数字电子学不同,在集成光子学中,乘法、积累和更一般的线性代数运算可以固有地、非迭代地执行,得益于信号的电磁特性和有效的光物质相互作用所提供的内在并行性。在这方面,集成光子学是一个理想的平台,映射特定的复杂操作一对一到硬件,在某些情况下算法,实现时间复杂度。

[1] 冯·诺依曼架构为计算机大提速铺平了道路,却也埋下了一个隐患:在内存容量指数级提升以后,CPU 和内存之间的数据传输带宽成为了瓶颈。