Deepfake

眼见不一定为实

你玩过换脸软件吗?你看到过奥巴马大骂特朗普的视频吗?这些都是Deepfake的小打小闹。

Deepfake这个词是“深度学习”和“假冒”两个词的组合。

一般来说,Deepfake指的是由人工智能生成的、现实生活中不存在的人或物体,它们看上去是逼真的。

Deepfake的最常见形式是人类图像的生成和操控。例如,对外国电影进行逼真的视频配音,在购物时虚拟地穿上衣服,对演员进行换脸等等。

但Deepfake技术越来越多的运动到视频的深度伪造上,通过照片数据库、多个视频合辑、尽心设计、AI合成一段真假难辨的视频。

如果Deepfake成功地做到了瞒天过海,将引发灾难性的后果。

真假难辨

AI撒谎、防不胜防

就像假新闻可以传播伪造的录音一样,想象一下假视频里希拉里开玩笑说从投资银行拿了贿赂,或者普京承认她的邮件是他偷的。

如果Deepfake的视频出现再法庭上当作证据?那我们还能相信我们看到的么?

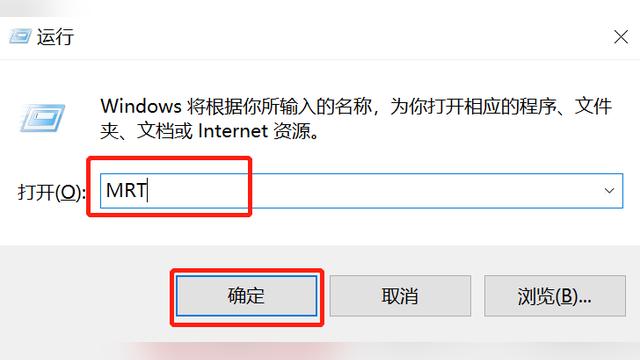

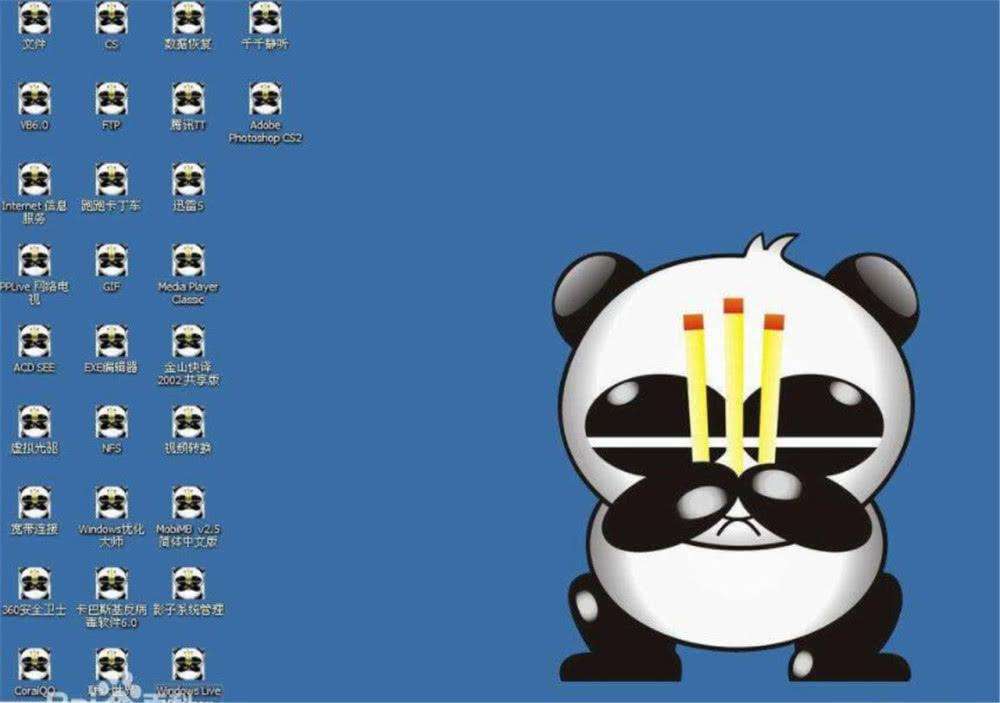

随着技术的不断进步,任何计算平台都可能出现漏洞及安全隐患,例如电脑病毒、信用卡盗用和垃圾电子邮件等。而且,随着AI的普及,AI本身也将暴露出各种漏洞并遭到各方的攻击,Deepfake反映出的只是其中的一个漏洞而已。

试想,如果有人把类似的攻击手段应用在军事领域,例如,让AI系统把一辆伪装过的坦克误认为是救护车,那么后果将不堪设想。

还有一种攻击AI系统的方法是对数据“下毒”:攻击者通过“污染”训练数据、训练模型或训练过程,来破坏AI系统的学习过程。这可能导致整个AI系统彻底崩溃,或者被犯罪者控制。

如果一个国家的军用无人机被恐怖分子操控,那么这些无人机将把武器掉转过来瞄准自己的国家,这将是多么可怕的事情。

与传统的黑客攻击相比,对数据“下毒”的攻击手段更难被人类察觉。问题主要出在AI系统架构上面——模型中的复杂运算全部在成千上万层的神经网络中自主进行,而不是按照确切代码的指引进行的,所以AI系统先天就具有不可解释性,也不容易被“调试”。

AI病毒

AI病毒时代来临你准好了吗?

尽管困难重重,但我们仍然可以采取明确的措施来阻止上述情况发生。例如,加强模型训练及执行环境的安全性,创建自动检查“中毒”迹象的工具,以及开发专门用于防止篡改数据或与其类似的规避手段的技术。

正如我们过去通过技术创新攻克了垃圾邮件、电脑病毒等一道道关卡一样,我深信技术创新也能大大提高未来AI技术的安全性,尽量减少给人类带来的困扰。

毕竟,解铃还须系铃人。技术创新所带来的问题,最终还是要依靠新的技术创新来进行改善或彻底解决。