Python爬虫全网抓取知乎答案!

在当今信息时代,人们对于各种问题的解答,往往会在网络上寻找答案。而知乎作为一个集众多优秀用户分享经验与知识的平台,受到了广大网民的青睐。但是,对于某些问题,我们往往需要查看该问题下的所有回答才能找到最佳答案。而手动翻页查看显然十分繁琐,这时候,Python/ target=_blank class=infotextkey>Python爬虫就可以派上用场了。

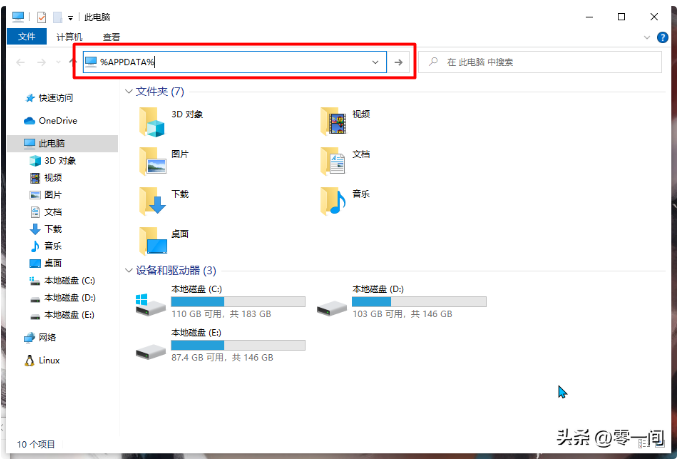

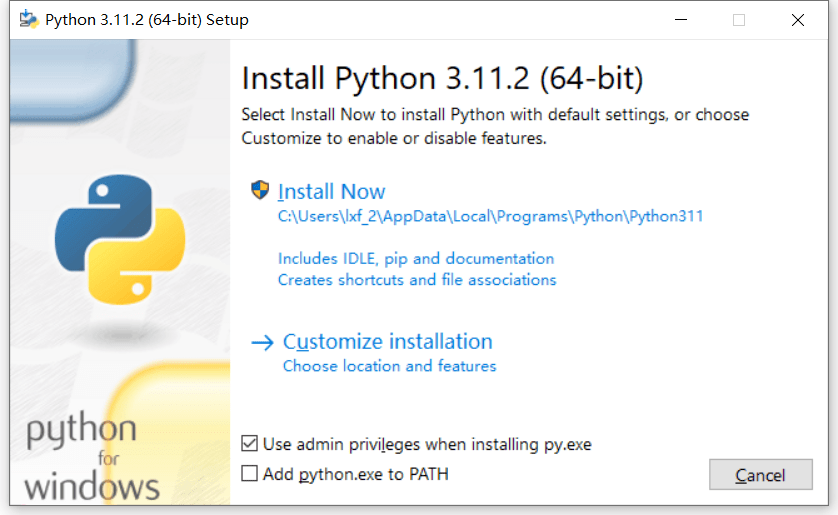

一、准备工作

在进行爬虫之前,需要进行一些准备工作。首先需要安装Python开发环境以及相关库文件。本篇文章使用Python3.9.0版本,相关库文件包括requests、beautifulsoup4和pandas等。

二、获取问题ID

要想爬取知乎问题下全部回答,首先需要获取该问题的ID。可以通过访问该问题页面,在浏览器的控制台中查看页面源代码,找到包含问题ID的元素,并进行提取。

三、获取回答总数

在进行爬虫之前,需要先获取该问题下回答的总数。可以通过访问API接口,并解析返回结果获得总数。

四、构造URL

有了问题ID和回答总数,我们就可以构造出获取回答信息的URL。通过循环访问该URL,并解析返回结果获得所有回答内容。

五、解析html

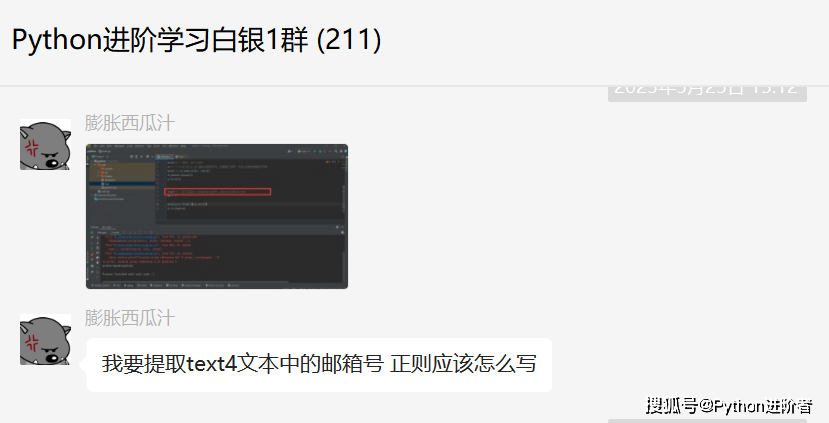

获取到回答信息后,需要对HTML进行解析,提取出所需内容。可以使用beautifulsoup4库进行解析,并通过正则表达式提取出所需数据。

六、数据存储

在爬取完所有数据后,需要将其存储在本地。可以使用pandas库将数据转换为DataFrame格式,并保存为Excel或CSV文件。

七、反爬处理

在进行爬虫时,需要注意反爬处理。可以通过设置请求头、使用代理IP等方式规避反爬机制。

八、注意事项

在使用Python爬虫时,需要注意以下几点:

1.尊重网站的robots协议,不要频繁访问同一页面;

2.遵守网络道德规范,不要使用爬虫程序进行非法活动;

3.注意隐私保护,不要将用户个人信息公开;

4.不要对网站造成过大的负担,避免给服务器带来压力。

以上就是Python爬虫爬取知乎问题下全部回答的详细步骤。通过这些步骤,我们可以轻松地获取知乎问题下的所有回答,并进行数据分析和挖掘。