读懂2023中国AIGC商业潜力研究报告

在人工智能发展的漫长历程中,如何让机器学会创作一直被视为难以逾越的天堑,“创造力”也因此被视为人类与机器最本质的区别之一。然而,人类的创造力也终将赋予机器创造力,把世界送入智能创作的新时代。

从机器学习到智能创造,从 PGC,UGC 到 AIGC,我们即将见证一场深刻的生产力变革,而这份变革也会影响到我们工作与生活的方方面面。

预学习引发AI技术质变,摆脱过去AI的高门槛、训练成本高、生成内容单一的痛点。基于大模型的泛化能力,知识蒸馏与微调后进入专用领域的应用,覆盖短头、长尾的场景。多模态打破多种信息之间的边界,提升AIGC内容多样性与技术多样性,拓宽应用的场景。

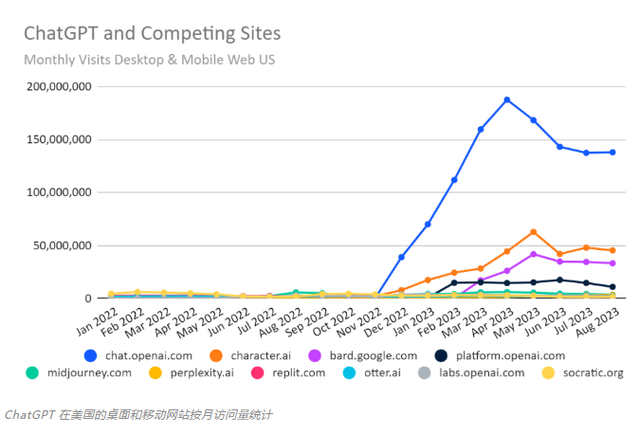

中外差距:中国生成式 AI 与国外先进水平存在一定差距,但凭借国内应用场景的多样性,具备AIGC的数据积累优势,有望追上先进步伐。

AIGC 概述

AIGC(AI Generated Content)是基于 GAN、预训练大模型、多模态技术融合的产物,通过已有的数据寻找规律,并通过泛化能力形成相关内容。

从商业角度看,AIGC 是一种赋能技术,通过高质量、高自由度、低门槛的生成方式为内容相关场景及生产者进行服务。

早期决策式 AI 依赖逻辑判断的纯粹性,万物都能完美观察、任何测量不存在误差的前提,不符合真实世界的“不确定性”;概率范式基于经验主义与理性主义一定程度上解决了“不确定性”;深度加强学习可以利用合理的数据丰度与奖惩模型达到类人类智能的水平,实现高质量内容与内容创作自动化;通用型 AI 具备泛人类智能,可以像人类一样执行各种任务。

决策式 AI

AI 在早期工作在于关注逻辑、自动定理证明和操纵各种符号,该类 AI 理解基础的物理知识,具备一定的逻辑能力,通过分析数据和信息,帮助使用者更好的做出判断与决策。但基于逻辑的 AI 缺乏感知能力,对真实世界普遍存在的“不确定性”较难处理。概率与统计可以初步解决“不确定性”,但是概率范式需要经验主义先于理性主义进行填充。以 Bayes 模型为例,需要 经验主义者先设定先验数据。

生成式 AI

以数据为中心,深层次的网络堆叠为架构,样本数据及数据种类的丰富,训练的模型泛化能力就越强,效果越好。同时深度学习训练 AI 已经可以很好的执行任务。不过,强化学习的效果却不一定受到数据丰度的影响。强化学习遵循 Markov 原则,只要奖惩设计合理就能实现不错的效果。

通用型 AI

具备泛人类智能的 AI,可以像人类一样执行各种任务。历次 AI 寒潮沉淀的技术,终在算法、算力、数据三者共振的情况下诞生出大模型。

在1956年的达特茅斯会议上,“人工智能”的概念被首次提出,六十多年以来,历经逻辑推理、专家系统、深度学习等技术的发展,人工智能也经历了数次沉浮,有如日中天的发展时期,也有因技术不足热度退去后的寒潮。而每一次寒潮后,也会经历技术的蛰伏发展,为人工智能带来里程碑式的进步。

预学习的出现解决了过去生成式大模型的痛点,但预学习本身存在模型尺寸、小样本数量、微调能力的不可能三角,解决方法也不尽相同:对于极大模型,使用知识蒸馏;对于少样本学习能力,进行数据增强;对于监督训练表现欠佳的模型,进行提示学习。

以 GPT 为例,在目前阶段,厂商通常的做法是扩大模型尺寸。

预学习大模型的出现解决了过去各类生成式模型使用门槛高、训练成本高、内容生成简单和质量偏低的痛点,满足真实内容消费场景中的灵活多变、高 精度、高质量等需求。

预学习思路

• 将大量低成本收集的训练数据集中,学习其中的共性;

• 然后将其中的共性移植到特定任务的模型中,再进行微调,去学习该特定任务的特性部分。

AI 大模型底座驱动 AIGC 概念落地

在 AIGC 概念实际落地的过程中,只有基础大模型与通用技术是远远不够的,还需要能与场景融合匹配,更需要支持应用落地的工具平台和开放包容的创新生态,三者协同优化,加速 AIGC 落地。

在全应用流程中,主要通过大量的无标注文本进行共性学习,获得预训练大模型,此后再根据应用场景特征进行微调,更好与项目任务适配。

多模态打破多种信息之间的边界并生成质量稳定的内容,提升 AIGC 内容多样性。相比于信息模态单一的单模态模型,多模态模型可以同时处理更多模态的信息并将它们相互转化。

现今多模态模型以图文多模块为主。Transformer 虽受制于单模态但其权重共享适用于多模态;ViT 模型处理输入图片,使得 Transformer 可用, 从而打破 NLP 和 CV 间屏障;BEiT 将生成式预训练从自然语言处理迁移到了计算机视觉;扩散模型多用于文本图像生成。

多模态信息持续融合增加技术多样性,拓宽场景。多模态在视频分类、情感分析、语音识别等领域都得到了广泛应用,涉及图像、视频、语音、文本等融合内容,未来还将进入交互、感知、内容等更多应用场景。

中国决策式 AI 已达到世界一流水平,而生成式 AI 还与国外存在基础要素的不足。

在决策式 AI 方面,中国已经处在第一梯队,中国是发表 AI 论文最多的国家,且近 10 年来占比逐年增加。而在生成式 AI 方面,与国外还存在参数量的差距,背后隐含着算力资源、数据质量等基础要素的不足的原因。

AIGC 的原子能力随着时间的变化,内容呈现复杂化、多维化的特征,基础模态原子能力向多模态转变,表明目前 AIGC 商业应用的尝试正下沉至长尾场景,大模型的泛化能力、实时性、强推理与共情能力正在不断渗透为虚拟人、聊天机器人、知识图谱、合成数据、AIGS 进行多维度的赋能, 推动通用人工智能时代到来。

短期内算力成本占据生态圈核心,算法与配套的数据价值在远期凸显。

AIGC 大模型的训练、微调和运营需要大量的计算资源支撑,目前算力占据 AIGC 生态圈 65%成本,数据及算法占据剩下 35%的成本。

从短期看,一头独大的格局不会发生太大变化,大模型新入局玩家的算法训练和老玩家大模型的微调、迭代将会持续刺激算力成本上扬。

从长期看,有望出现三头并进格局,模型算法的迭代会成为 AIGC 通往 AGI 的解决方案,随着应用不断下沉长尾的专用场景,专用算法及场景沉淀的数据将会成为 AIGC 体验的核心,另外,合成数据及减少算力依赖的框架算法成熟将会加大缓和算力紧张的缺口。

随着数字经济蓬勃发展,数字化新事物、新业态、新模式推动应用场景向多元化发展,扩大算力是 AIGC 短期内最需要解决的问题。在后摩尔时代,算力供给和需求都会飙升,据预测,中国智能算力规模将会拥有47.5%的年复合增长率,但与智能算力需求仍存在较大差距。

中国算力需求剪刀差。算力构成了 AIGC 产业的核心底座,主要包括 AI 芯片、AI 服务器和数据中心。

AI 芯片:是算力的基础,主要分为 CPU、GPU、FPGA、ASIC 四类。CPU 是人工智能计算的基础,而 GPU、FPGA 和 ASIC 为协助 CPU 进行大规模计算的加速芯片。

AI 服务器:对 AI 芯片进行系统集成。AI 服务器的架构为“CPU+加速芯片”,在进行模型处理推理和训练时,效率更高。

数据中心:提供计算服务,承接 AI 算力需求。AIGC 使用算力资源在云端实现模型训练。

短期内 GPU 不可撼动,但随着 AI 任务比例变化,FPGA 及 ASIC 有望远期成为主力 AI 芯片。

短期看,GPU 占据 AIGC 训练及推理的绝对地位,英伟达基于 CUDA 强大的并行计算能力及自身产品力构建了护城河;远期看,FPGA 及 ASIC 芯片时延低、特需设计等特点将成为主力芯片,国内厂商凭借两者的多年积累有望加速 AI 芯片的自主化进程。

缺乏优质数据,让中文大模型患上“心脏病”。

AIGC 由 PGC 和 UGC 进行内容支撑,缺乏过往内容的将会直接性影响 AIGC,缺乏高质量的中文数据资料,将会影响到中文大模型在知识领域的能力。

此外,国内拥有大量高价值数据的互联网企业更倾向于将数据封闭在 App 和平台中,不同 APP 间数据不能连通,无法进行搜索,形成“数据孤岛”现象。

数据马太效应或导致中国大模型难以获得商业循环的支撑。

由于英文数据和中文数据之间的指数级别的差距,建立在数据之上的模型也会出现越来越大的差距,形成数据马太效应。

数据马太效应或导致英文大模型获得更多的商业机会,中文大模型亟需大量高质量的标注数据提升模型能力。

中文高质标注数据是国内大模型能力跻身国际先进水平的充要条件。

数据工程是 AI 工程的基础环节,其核心在于高质高效的数据标注,数据工程所得出的数据的质量,直接影响到整个模型的质量与精度。

中国数据量呈指数级增长,其中大占比的非结构化数据产生海量数据标注与清洗的需求,未来市场前景广阔。

开发通用大模型成为 AIGC 应用的底座。算法模型是人工智能的“灵魂”,通过建立算法模型并进行下行研发实现 AI 资产的复用获得盈利。

盈利方式通过大模型使用授权、行业大模型定制、工作流订阅及基于下游任务微调三种途径进行订阅模式、平台服务模式、定制化服务模式、API 服务模式、广告和推广模式、数据授权模式的商业变现。

目前大模型生成应用服务以 B 端为主,平台服务模式占比相对较高。作为服务提供商,AIGC 向 B 端和 C 端用户提供生成内容的技术平台和工具,并通过收取平台使用费、交易手续费、广告和推广收益以及数据授 权收益等方式获得收益。

在用户定位方面,AIGC 主要面向 B 端用户,如媒体、广告主、文化机构等,以及开发者、科研机构等需要使用生成内容技术的用户。

订阅模式

定义:用户通过订阅服务,定期或按需获取人工智能生成的内容。

案例:OpenAI:提供了GPT-3 订阅服务;Grammarly:提供英文语法和写作帮助的订阅服务。

平台服务模式

定义:AIGC 提供生成内容技术平台和工具,通过收取平台使用费获得收益。

案例:google Cloud AI:提供各种 AI 平台服务。

定制化服务模式

定义:公司可以根据客户的特定需求,提供定制化的人工智能生成内容服务。

案例:Hugging Face:提供NLP领域的开源软件,同时也提供定制化的 NLP 服务。

API 服务模式

定义:公司提供人工智能生成内容的 API,供开发者集成到自己的应用程序中。

案例:Google Cloud Vision API:提供基于图像和视频的视觉智能 API 服务。

广告和推广模式

定义:人工智能生成的内容可以作为广告或推广渠道,通过展示广告或推广内容来获得收益。

案例:阿里巴巴“文娱大 脑”:为企业生成各种类型的广告文案。

数据授权模式

定义:人工智能生成的内容可以作为数据的授权和授权来源,被其他公司或个人购买或授权使用。

案例:OpenAI:将GPT3的API授权给了 Microsoft 和 Github 等公司。

整体来看,数据和算力是大模型性能的关键限制因素,而算法的不断改进是让大模型接近其上限能力的关键,同时也是商业变现的“接口”。

AIGC 生态底座服务商会形成以互联网企业的通用大模型+行业大模型+原子基础能力的泛化派玩家,以大模型 AI 服务商、行业/垂直领域 AI 服务商为主的专用派服务商,结合企业自身过去的业务与技术强化 AIGC 在长尾场景的应用能力。