linux网络编程常见API详解

linux网络编程API函数初步剖析

今天我们来分析一下前几篇博文中提到的网络编程中几个核心的API,探究一下当我们调用每个API时,内核中具体做了哪些准备和初始化工作。

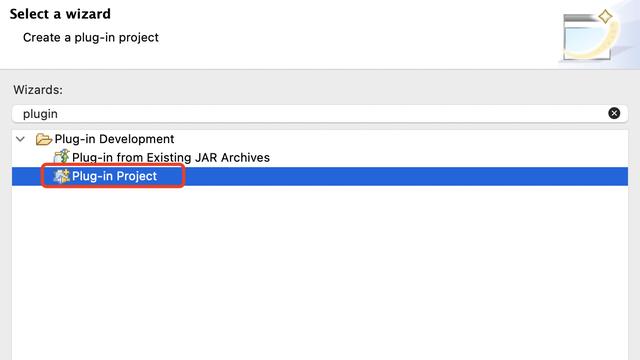

1、socket(family,type,protocol)

当我们在开发网络应用程序时,使用该系统调用来创建一个套接字。该API所做的工作如下所示:

该系统调用主要完成两个任务:“创建套接字”和“为套接字绑定文件句柄”。

socket{}<include/linux/net.h>结构定义如下:

struct socket {

socket_state state; //socket状态

unsigned long flags; //标识,如SOCK_ASYNC_NOSAPCE

const struct proto_ops *ops; //协议特定的socket操作集

struct fasync_struct *fasync_list; //异步唤醒队列

struct file *file; //指向文件的指针

struct sock *sk; //指向下一层中的sock结构

wait_queue_head_t wait; //等待在这个socket上的任务列表

short type; //数据包的类型

};

在创建socket套接字时,就是要完成ops、file和sk等这些成员的初始化。

1). 创建套接字:sock_create()

根据family参数值在全局数组struct net_proto_family net_families[]里找到我们所指定的地址簇。不同类型的地址簇都有一个struct net_proto_family{}类型的对象,例如我们常见的IPv4的inet_family_ops,IPv6的inet6_family_ops,X25协议的ax25_family_ops等。在内核是初始化时,这些模块会在自己的初始化函数内部调用sock_register()接口将各自的地址簇对象注册到net_families[]数组里。

我们分析的焦点集中在IPv4协议簇,即inet_family_ops对象上。重点是inet_create函数,该函数的主要任务就是创建一个socket套接字,并对其中相关结构体成员进行必要的初始化。至于它创建套接字时的依据和原理等到我们讲协议栈时大家就明白了,这里主要是让大家对其流程执行流程有个感性的把握。

sock_alloc()函数中我们创建一个struct socket{}类型的对象,假如叫做A,将socket()系统调用的第二参数type字段赋值给A->type。

在inet_create()函数中,我们根据type的值,在全局数组 struct inet_protosw inetsw[]里找到我们对应的协议转换开关。而inetsw[]数组是在inet_init()函数里被初始化的:

其中inetsw_array[]是一个比较重要的数据结构,定义在af_inet.c文件中:

根据type的值,就可以确定struct socket{}->ops,到底是inet_stream_ops、inet_dgram_ops或者inet_sockraw_ops。然后,对应地,就以tcp_prot、udp_prot或raw_prot为输入参数,实例化一个struct sock{}对象sk=sk_alloc()。紧接着建立socket{}和sock{}的关联,最后将socket()系统调用的第三个参数protocol付给sock{}对象中的属性sk_protocol。

看不懂别着急,我说过,这里只是给大家梳理整体流程,等到我们讲了协议栈章节,然后再回头看本篇,就感觉这些东西就太小儿科了。

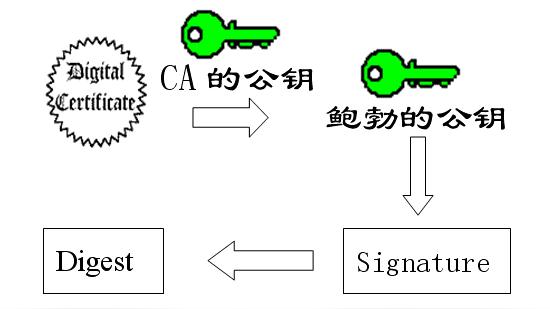

2). 为套接字绑定文件句柄:sock_map_fd()

我们都知道网络套接字也是一种系统IO,所以不可避免的要与文件系统打交道。每个套接字都对应一个已打开的文件标识符,所以在套接字初始化完成后,就要将其和本地一个唯一的文件标识符关联起来,即建立socket{}和file{}之间的关联关系。

2、bind (sockfd, sockaddr, addrlen)

该系统调用在内核中的执行过程如下:

重点是socket->ops->bind()回调接口。我们现在已经知道了,针对IPv4而言,这里的ops无非就是inet_stream_ops、inet_dgram_ops或inet_sockraw_ops对象。碰巧的是,这三个对象中的bind函数指针均指向inet_bind()函数。只有原始套接字的情况,这里会去调用raw_prot对象的bind回调函数,即raw_bind()。

3、listen(sockfd, backlog)

这里我们可以看到面向无连接的套接字和原始套接字是不用listen的,只有流式套接字才有效。

4、connect(sockfd, sockaddr, addrlen)

从这幅图中我们确实看到,connect()系统调用不但可以面向连接的套接字,也可用于无连接及原始套接字。

5、accept(sockfd, sockaddr, addrlen)

同样地,我们看到只有面向连接的流式套接字调用accept()才有意义。最终调用的是tcp_prot对象的accept成员函数。

需要C/C++ Linux高级服务器架构师学习资料后台私信“资料”(包括C/C++,Linux,golang技术,Nginx,ZeroMQ,MySQL,redis,fastdfs,MongoDB,ZK,流媒体,CDN,P2P,K8S,Docker,TCP/IP,协程,DPDK,ffmpeg等)

Linux网络编程数据收发的API流程分析

只要把数据在协议栈中的流动线路和脉络弄清楚了,关于协议栈的实现部分,理解起来就轻松多了。在网络编程章节的数据接收过程中,我们主要介绍过read()、recv()、recvfrom()还有一个recvmsg()没介绍到,今天我们就来看一下这几个API函数到底有什么差别。

数据接收

在接收数据的过程,主要分两个阶段:BOTTOM-HALF和TOP-HALF。 BOTTOM-HALF:

当从网卡驱动收到数据包后即进入BOTTOM-HALF阶段,在这里要根据以太帧头部中的类型字段来确定上层承载的具体协议类型,如IP,或ARP、RARP等。IP报文的处理函数通常交付给ip_recv()函数来处理,然后数据进入网络层,具体流程: 如果该数据包是发给本机的一般调用ip_local_deliver()函数,如果是需要本机转发给出去的,并且本机也开启了转发功能,那么就会调用ip_forward()函数。 在这里我们看到了Netfilter的身影,好久没看到它了,还是有些亲切。大家可以结合这幅图回头再理解一下Netfilter和协议栈的关系。 BOTTOM-HALF最后将收到的skb填充到socket套接字的接收队列里,参见下图。

TOP-HALF:

紧承BOTTOM-HALF阶段,该阶段的主要任务就是从接收队列里拿出一个skb然后将其传递到用户空间去,如下:

可以看出,这几个函数的内部最终都统一到了一起:__sock_recvmsg()。

数据发送

同样的,数据发送也分两个阶段,对照接收的情况,发送数据时肯定也存在一个发送队列,这样想就对了。前面关于发送数据包时我们介绍过的API有write()、send()、sendto()还有一个sendmsg()没介绍到。 TOP-HALF如下:

BOTTOM-HALF如下所示:

经过这么一份探索,我们对这几个数据收发的API至少理解的要比别人深刻些了吧。