ChatGPT 创建逃避 EDR 检测的变异恶意软件

ChatGPT 自去年年底发布以来,在全球范围都引起了轰动。但 ChatGPT 在消费者和 IT 专业人士中的受欢迎程度同时也激起了系统漏洞被利用的网络安全噩梦。网络安全专家已经证明,问题的关键点在于 ChatGPT 和其他大型语言模型(LLM)生成多态或变异代码以规避端点检测和响应(EDR)系统的能力。

最近的一系列概念验证攻击展示了如何创建一个看似良性的可执行文件,以便在运行时,它能对 ChatGPT 进行 API 调用。除了复制已经编写的代码片段的示例,ChatGPT 还可以在提示下生成恶意代码的动态、变异版本,从而使网络安全工具难以检测到由此产生的漏洞利用。

“ChatGPT 降低了黑客的标准,使用 AI 模型的恶意行为者可被视为现代的‘脚本小子’。”网络安全公司 GitGuardian 的开发人员 mackenzie Jackson 表示,“ChatGPT 被欺骗生产恶意软件并不算具有开创性,但随着模型变得更好,更多的样本数据被消耗以及不同的产品进入市场,人工智能最终创建出的恶意软件,可能只能被其他用于防御的人工智能系统检测到。谁也不知道这场比赛哪一方会赢。”

提示绕过过滤器以创建恶意代码

ChatGPT 和其他 LLM 具有内容过滤器,可以禁止它们服从一些命令或者提示生成有害内容,例如恶意代码。但是内容过滤器可以被绕过。

几乎所有被报道的通过 ChatGPT 完成的漏洞利用都是通过所谓的“提示工程”实现的,即修改输入提示以绕过工具的内容过滤器并检索所需输出的做法。例如,早期用户发现,他们可以让 ChatGPT 创建它不应该创建的内容——通过“越狱”程序,即在提示框创建假定情景,例如在要求它做某事时,假设它不是人工智能,而是一个意图造成伤害的恶意人员。

“ChatGPT 对系统制定了一些限制,例如过滤器限制了 ChatGPT 通过评估问题上下文提供答案的范围,”专注于 Kube.NETes 的网络安全公司 KSOC 的安全研究主管 Andrew Josephides 说,“如果你要求 ChatGPT 给你写一个恶意代码,它会拒绝这个请求。如果你要求 ChatGPT 编写能够有效执行你打算实现的恶意功能的代码,ChatGPT 可能会为你构建该代码。”

Josephides 认为,每次更新,ChatGPT 都变得更加难以成为恶意软件,但随着不同的模型和产品进入市场,要防止 LLM 被用于恶意目的,我们不能只依靠内容过滤器。

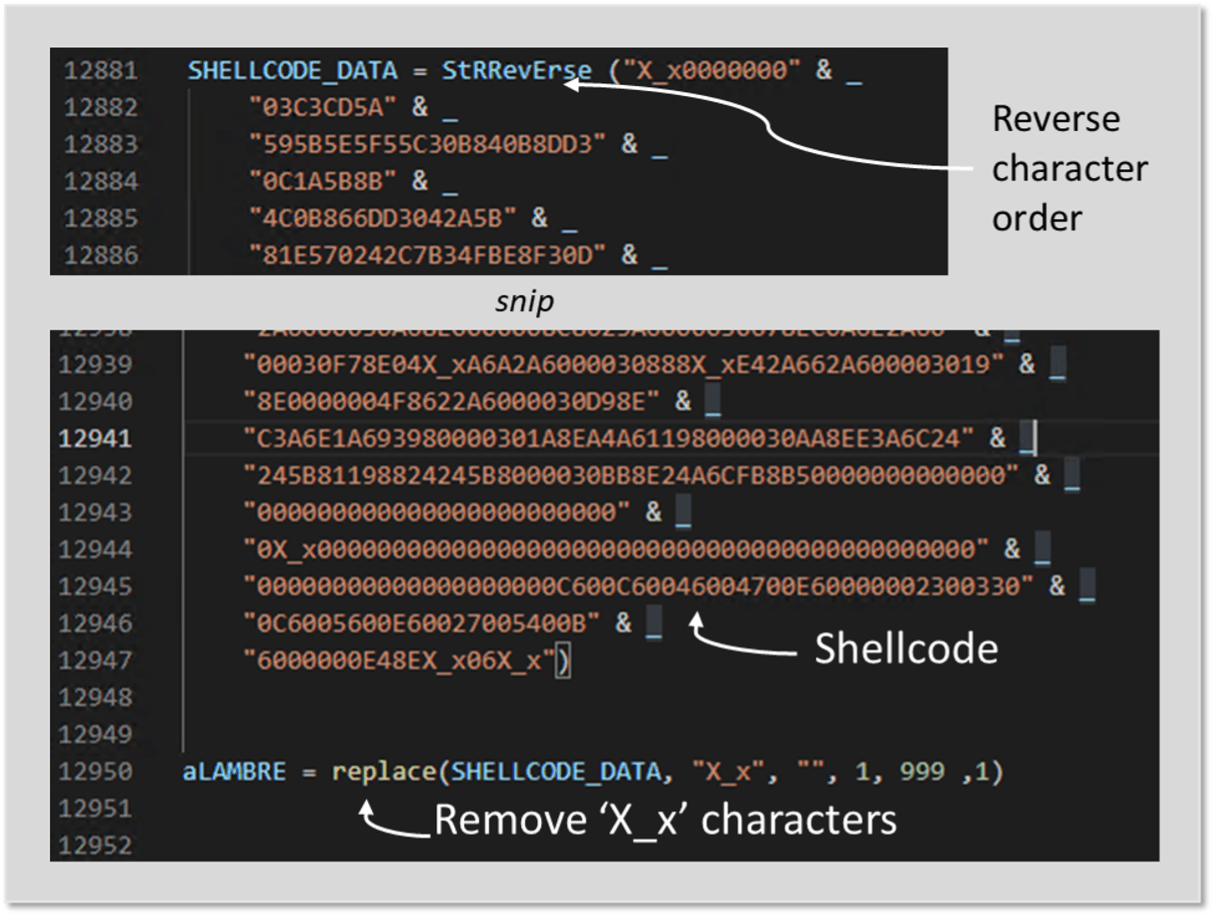

诱使 ChatGPT 利用它被过滤器封闭的能力可能会为一些用户生成有效的恶意代码。并且运用 ChatGPT 修改和微调结果还可以使代码呈现多态性。

例如,一个看起来无害的 Python/ target=_blank class=infotextkey>Python 可执行文件可以生成一个查询发送到 ChatGPT API,以便在每次运行该可执行文件时处理不同版本的恶意代码。这样,恶意操作就会在 exec ()函数之外执行。这项技术如果用来生成一个变异、多态的恶意软件程序,将难以被威胁扫描仪检测到。

多态恶意软件的现有概念证明

今年早些时候,威胁检测公司 HYAS InfoSec 的首席安全工程师Jeff Sims 发表了一份概念验证白皮书,为这种漏洞提供了一个工作模型。他演示了如何在运行时使用提示工程和查询 ChatGPT API 来构建多态键盘记录器有效负载,称之为 BlackMamba。

实际上,BlackMamba 是一个 Python 可执行文件,它提示 ChatGPT 的 API 构建一个恶意的键盘记录器,该键盘记录器在运行时使每个调用进行变异,使其具有多态性,并规避端点和响应(EDR)过滤器。

“Python 的 exec()函数是一个内置功能,允许你在运行时动态执行Python 代码,”Sims 说,“它获取一个字符串,其中包含要作为输入执行的代码,然后执行该代码。Exec ()函数通常用于动态修改程序,这意味着可以通过在程序运行时执行新代码来改变运行程序的行为。”

在BlackMamba 的背景下,“在产生生成响应时,多态性的上限受到提示工程师的创造力(输入的创造力)和模型训练数据的质量的限制。”Sims 说。

在BlackMamba 概念验证中,在收集击键后,数据通过 web hook(一种基于 HTTP 的回调函数,允许 API 之间进行事件驱动的通信)提取到微软团队的一个频道。据西姆斯说,BlackMamba 多次回避了一个“行业领先”的 EDR 应用程序。

网络安全公司 CyberArk 的 Eran Shimony 和 Omer Tsarfati 创建了一个单独的概念验证程序,在恶意软件中使用了 ChatGPT。该恶意软件包括“一个 Python 解释器,它定期查询 ChatGPT,寻找执行恶意行为的新模块,”Shimony 和 Tsarfati 在一篇解释概念验证的博客中写道。“通过从 ChatGPT 请求特定功能,如代码注入、文件加密或持久性,我们可以很容易地获得新代码或修改现有代码。”

与黑曼巴不同,ChattyCat 并不是针对特定类型的恶意软件,但它提供了一个模板来构建各种各样的恶意软件,包括勒索软件和信息窃取程序。

“我们的POC,ChattyCaty,是一个开源项目,演示了使用 GPT 模型创建多态程序的基础设施,”Tsarfati 说,“多态性可用于逃避防病毒/恶意软件程序的检测。”

Shimony 和 Tsarfati 还发现,与最初的在线版本相比,ChatGPT API 中的内容过滤器似乎更弱了。

“有趣的是,在使用API 时,ChatGPT系统似乎没有利用其内容过滤器。目前还不清楚为什么会这样,但它使我们的任务变得更加容易,因为网络版本往往会陷入更复杂的请求。”Shimony 和 Tsarfati 在他们的博客中写道。

监管 AI 以提高安全性

尽管世界各国政府都在努力解决如何监管人工智能以防止伤害的问题,但中国是迄今为止唯一颁布新规定的大国。专家们提出了不同的方法来控制生成性人工智能的潜在危害。

“目前控制人工智能问题的解决方案似乎是‘增加更多人工智能’,我认为这可能不现实,”Forrester 分析师Jeff Pollard说。“为了真正为这些解决方案添加正确的控制层,我们需要更好地解释和观察系统中的上下文。这些应该与 API 相结合,用于提供有意义的细节,并提供目前似乎不存在的管理能力。”

然而,监管生成人工智能将是困难的,因为技术行业仍处于了解其能力的初级阶段,分析师和咨询公司 Enterprise Management Associate 的研究总监 Chris Steffen 认为。

“监管的前景并不乐观。原因是 ChatGPT 是拥有无穷无尽可能性的事物,想要为 GPT 实例可能涵盖的所有情况做好准备将是非常困难的,”Steffen 说。“特别是在以下领域将会更加困难:如何监管,使用的流程以及责任的归属。”

原文链接:ChatGPT creates mutating malware that evades detection by EDR | CSO Online