让NPC和玩家实时交互?英伟达展示的新AI技术做到了

虽然是新技术,但是已经有人在用了。

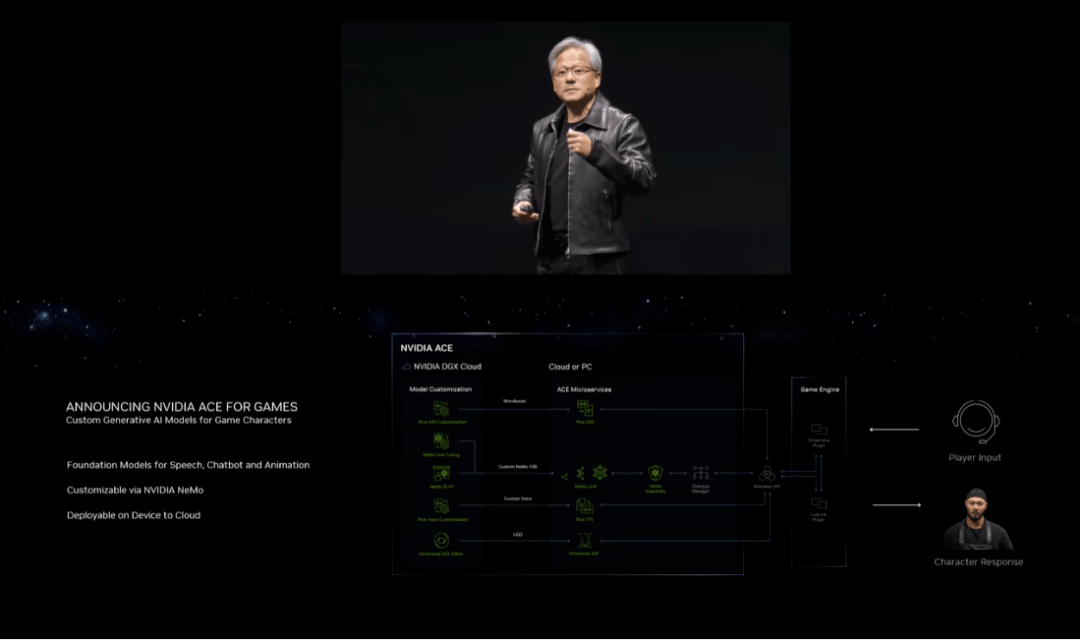

5月29日,在中国台北举办的2023年台北国际电脑展(Computex)上,英伟达首席执行官黄仁勋开始了他长达两小时的主题演讲。

作为演讲前半部分用于吸引观众眼球的重头戏,黄仁勋公布并介绍了英伟达和合作伙伴ConvAI共同构建的新AI技术:Omniverse Avatar Cloud Engine(以下简称ACE)。

ACE是一套基于生成式AI技术的模型代工服务,能够为游戏中的语音、对话和角色动画提供AI模型,或者说,给NPC添加实时交互的功能。“……我们用AI来渲染场景,还能用它让场景变得栩栩如生。”

黄仁勋还播放了一段代号“Kairos”的演示视频。这段视频运用虚幻5引擎和光线追踪技术,渲染了一间赛博风格的拉面店,由玩家操控的Kai来到店里,和AI驱动的NPC老板Jin实时交流。他们的对话翻译如下:

Kai:嗨,Jin,你还好吗?

Jin:不幸的是,不太好。

Kai:怎么了?

Jin:我担心这附近的犯罪活动。最近情况变得很糟。我的拉面店也陷入了交火之中。

Kai:我能帮忙吗?

Jin:如果你想为此做些什么,我听说了这样的传言。Kumon Aoki,那个强大的犯罪头目,正在城市里制造各种各样的混乱。他可能是这些暴力行为的根源。

Kai:我会跟他谈谈。我在哪里能找到他?

Jin:我听说他常去城东边的地下搏击俱乐部。试试去那里吧。

Kai:OK,我会过去的。

Jin:小心点,Kai。

搞这一大段对话的目的,就是让玩家接了个支线任务,找到这个Kumon Aoki,还拉面店一片清净。

Jin的对话都是AI“即兴创作”的产物,只是视频中的对话流程乏善可陈,和之前的游戏中NPC照本宣科般的对话似乎没啥区别。Jin的确在结合世界观作出发言,但玩家的问题问得太过简单,我们无从得知英伟达AI的实际性能及应变能力。

不过,Jin对自然语言实时做出的面部反应,或者说口型,完全对得上他的发言,光这一点就足以技惊四座。

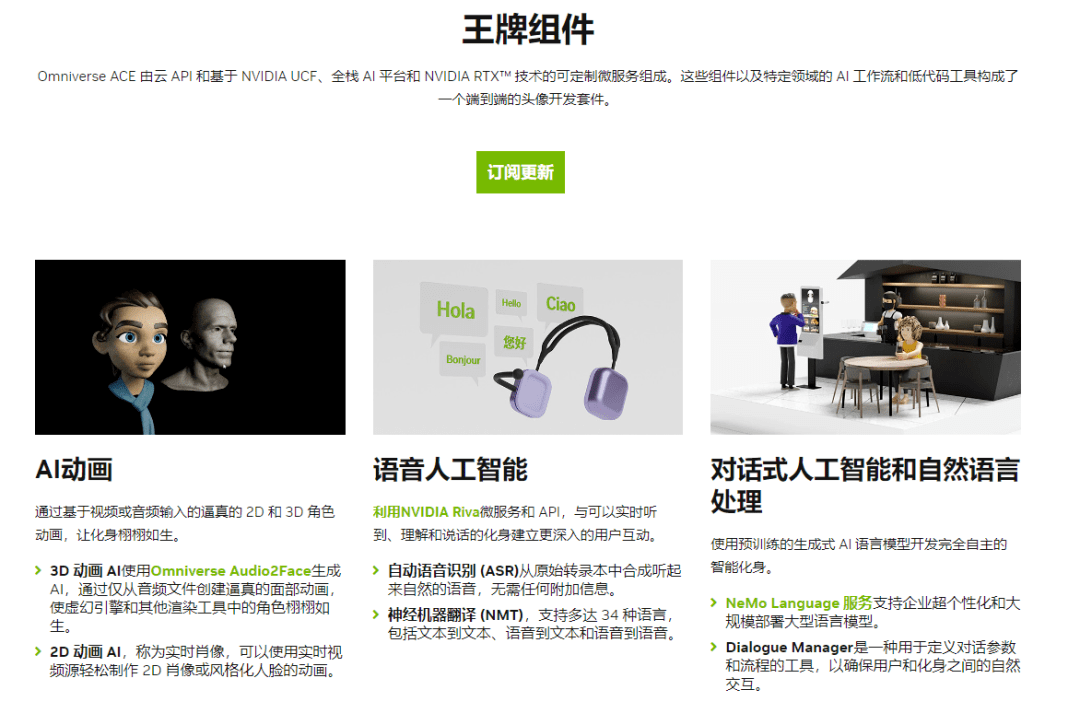

在ACE支持下的Jin“栩栩如生”,是英伟达的三种技术相辅相成的结果。

首先是NeMo,根据预先输入的知识和角色背景故事,构建、定制并部署语言模型,是NPC的大脑。

然后是Riva,用于识别玩家的语音、实现文本和语音互转,让NPC给出实时语音对话,是NPC的耳朵和嘴。

最后是Audio2Face,即时创建匹配语音的NPC面部动画,并直接添加到Epic的虚幻5引擎或其他工具中,可谓是NPC的面部神经。

图源英伟达官网

图源英伟达官网

Nvidia GeForce平台副总裁杰森·保罗(Jason Paul)在展前简报中表示,ACE可以一次用于多名AI角色,理论上甚至可以让NPC之间相互交谈。但他承认,他还没有看到过关于这方面的实际测试。

ACE是个代工服务,是英伟达向游戏开发人员出售的技术,旨在“让几乎所有开发人员都能以经济高效的方式设计由AI控制的NPC”。

当然,构成ACE的三项技术并非缺一不可,单买也没问题。据英伟达的新闻稿,一批游戏开发商和初创公司,已经在其工作流程中使用且仅使用了英伟达的Audio2Face技术。

例如,乌克兰游戏开发商GSC Game World,就准备在由虚幻5引擎打造的《潜行者2:切尔诺贝利之心》中试用Audio2Face,让NPC的口型对得上配音演员的声音。

《潜行者2》开发中画面

《潜行者2》开发中画面

老黄的演讲能够吸引多少游戏开发者买下ACE、又有多少开发者会因为这项技术革新受益或失业,暂且都是未知数。不过有一点可以确定:用于实现ACE效果的计算和渲染,需要更强大的显卡性能支撑。但愿英伟达在将来推出的新显卡,价格不会涨得太狠。