XR迎来核动力引擎:Meta开源最新AI算法

4月6日,Meta推出了一个AI模型Segment Anything Model(SAM,分割一切模型),能够根据文本指令等方式实现图像分割,而且万物皆可识别和一键抠图。

想必很多小伙伴已经看到了这个东西的介绍。对于XR的从业者来说,Meta的这个SAM模型可谓石破天惊,XR的发展突然就这么迎来了个强大的核动力引擎。

这个模型看起来是说可以“抠图”,但本质上它是实现了对图像的彻底的结构化。我们说文字类信息是结构化信息,但图像是非结构化的,而很多AI算法就是要解决图像数据结构化问题。但即使经历的多年的发展,此前AI也就能能够对一些特定类型的图像进行结构化,比如说数字、文字、人脸等。而Meta的SAM模型一次性实现了对图像中任意类型的目标进行结构化。

那么为什么说这个SAM对于XR的发展将起到核动力引擎的作用呢?

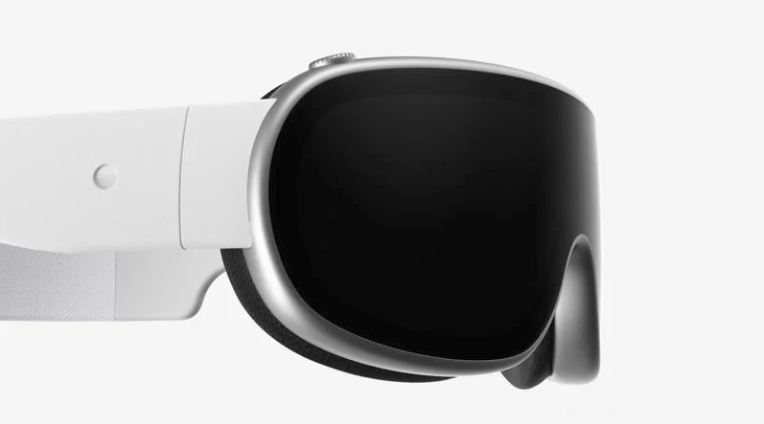

作为XR来说,一是要人感知世界,二是要世界感知人。但无论怎样感知,XR都需要首先能够理解世界上的万物,然后才能对其进行处理。但一直以来,都没有一个很高效的办法让XR通过图像去理解他“看到”的世界。

举个例子来说,假设小明戴着AR眼镜,拿起一根铁丝,走到一个插座面前,拿着铁丝去捅进插座,直到小明被活活电死,AR眼镜对这整个过程也会无动于衷,因为它无法通过图像识别对象,自然也无法理解小明在干嘛,更谈不上给小明发出任何的提醒了。

如果有了SAM模型的加持,AR眼镜就能够理解手、铁丝、插座等对象,当小明手持铁丝去做出危险动作时,AI就能通过AR眼镜给他发出危险提示。

当然,有了SAM模型加持的AR眼镜,不仅能够帮助人规避风险,也能够帮助人学做菜、学开车、学飞行、学织毛衣、学饲养小宠物,至于说学编程、学视频剪辑等更是不在话下。

警长现在能够想象到的场景一定只是SAM应用的一小部分。总而言之,XR在SAM的赋能下具备了通过图像理解现实的能力,无论是“增强现实”还是“虚拟现实”,在内容制作成本上会大幅降低,在使用场景上会大幅增加。SAM的出现,无异于为XR行业安装了一台核动力引擎,而且,已然按下了启动键。