轻松抓取网站文章,选对工具很关键!

随着互联网的不断发展,越来越多的信息被放在了网上,因此获取这些信息变得非常重要。本文将介绍如何抓取一个网站的所有文章。

一、了解网站结构

在开始抓取之前,我们需要了解目标网站的结构。通过查看源代码和分析URL可以找到每篇文章所在的页面。一些常见的页面类型包括文章列表页、分类页和标签页。

二、选择爬虫工具

有很多开源的爬虫工具可供选择,例如Scrapy、Beautiful Soup和Selenium等。这些工具都有其优缺点,需要根据自己的需求进行选择。

三、编写爬虫程序

使用所选的爬虫工具编写程序。程序应该包括以下功能:

1.获取目标网站的html源代码。

2.解析HTML源代码并提取文章链接。

3.访问每篇文章链接并获取文章内容。

4.保存文章内容到本地文件或数据库中。

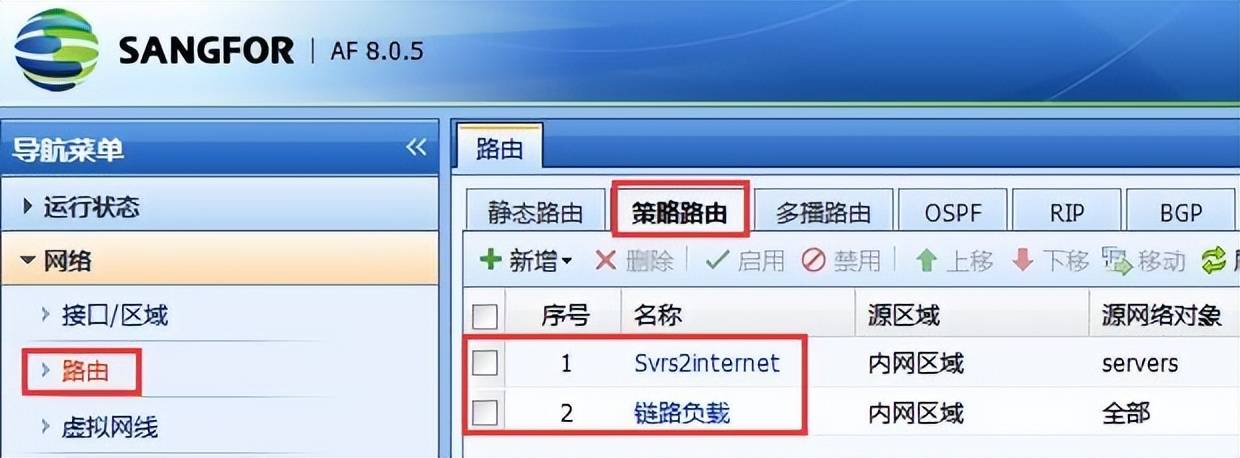

四、设置爬虫参数

在运行爬虫程序之前,需要设置一些参数以控制程序行为。例如:

1.爬虫速度:设置访问间隔时间以避免对目标网站造成过大负担。

2.网络请求头:设置网络请求头以模拟浏览器行为,避免被目标网站识别为爬虫。

3.数据保存方式:选择将数据保存到本地文件或数据库中。

五、运行爬虫程序

在设置好参数后,就可以运行爬虫程序了。程序将自动访问目标网站并抓取所有文章内容。运行过程中需要注意观察日志,及时发现和解决问题。

六、数据处理

抓取完成后,需要对数据进行处理。可能需要去除HTML标签、提取关键词、去除重复内容等等。

七、数据存储

处理完成后,需要将数据保存到本地文件或数据库中。这样可以方便后续的分析和使用。

八、注意法律风险

在抓取网站数据时,需要注意法律风险。一些网站可能禁止抓取其内容,如果被发现可能会面临法律风险。

九、总结

本文介绍了如何抓取一个网站的所有文章。通过了解网站结构、选择爬虫工具、编写爬虫程序、设置爬虫参数、运行爬虫程序、数据处理和存储以及注意法律风险等步骤,可以轻松地获取目标网站的所有文章。