Adobe研究人员研发新AI模型LRM:实现从2D样本瞬时生成3D图像

由Adobe Research和澳大利亚国立大学(ANU)联合研发的人工智能模型宣布了一项突破性的成果,能够从单一的2D图像中生成3D图像。

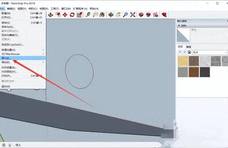

研究人员表示,他们的新算法在大规模图像样本上进行训练,可以在几秒钟内生成这样的3D图像。该算法采用了名为LRM(Large Reconstruction Model)的高度可扩展神经网络,包含一百万数据集和五亿参数,涵盖图像、3D形状和视频等多种数据。

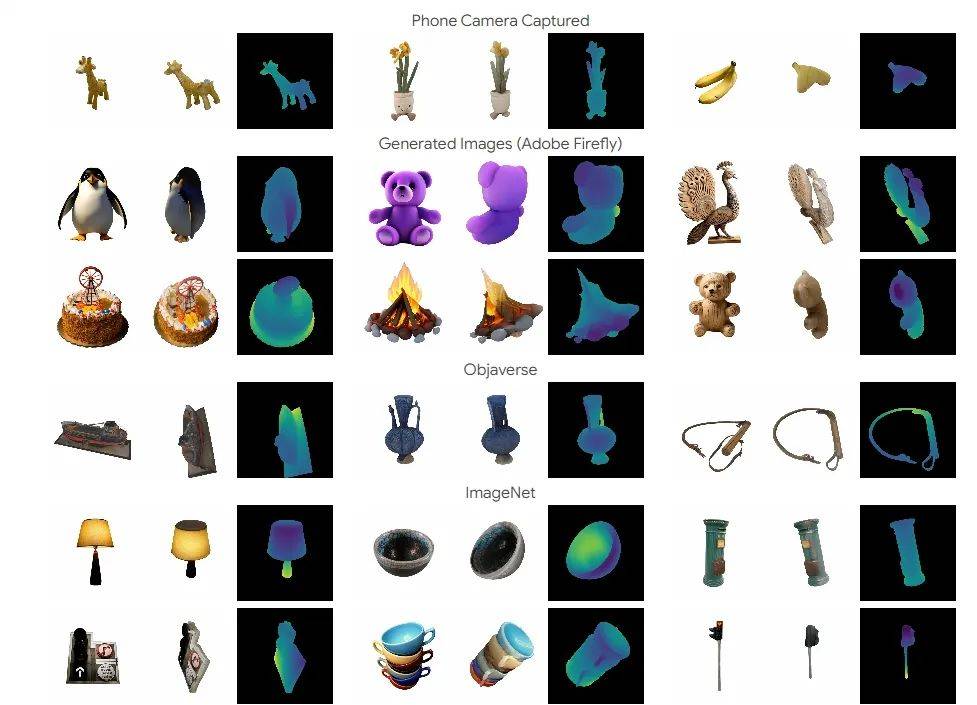

该项目的领导作者、澳大利亚国立大学工程、计算和控制学院的毕业生、Adobe实习生Yicong Hong表示:“这种高容量模型和大规模训练数据的结合使得我们的模型具有很强的泛化能力,能够从各种测试输入中产生高质量的3D重建。”

据Hong介绍,早期的3D成像软件只在特定主题类别中表现良好,后来的图像生成进展是通过程序如DALL-E和Stable Diffusion实现的,它们利用了2D扩散模型的卓越泛化能力以实现多视图。然而,这些程序的结果仅限于预训练的2D生成模型。

其他系统利用每形状优化来取得令人印象深刻的结果,但根据Hong的说法,它们“通常缓慢且不切实际”。他指出,利用大规模数据的巨大变压器网络内的自然语言模型的发展激发了他的团队提出一个问题:“是否可能学习从单一图像重建对象的通用3D先验?”他们的答案是“是”。

“LRM可以从现实世界中捕获的各种图像以及由生成模型创建的图像中重建高保真度的3D形状。” Hong说道,“LRM也是下游应用的高度实用解决方案,因为它可以在仅五秒钟内生成一个3D形状,无需后期优化。”

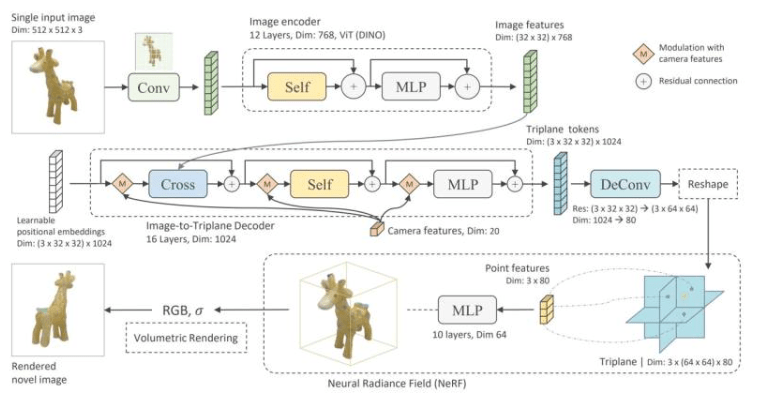

该程序的成功在于其能够利用数百万图像参数的数据库,并预测神经辐射场(NeRF)。这意味着它能够仅基于2D图像生成逼真的3D图像,即使这些图像是低分辨率的。与之前的3D软件相比,该模型的突破性在于其快速、高效地生成高质量的3D图像,为增强现实、虚拟现实系统、游戏、影视动画和工业设计等领域带来了转变。

总的来说,LRM(Large Reconstruction Model)是一种用于从单张图像生成高保真度3D物体模型的模型。LRM通过采用大规模数据和高容量模型的组合,实现了从单张图像到3D模型的快速而准确的重建。以下是LRM的主要功能特色:

1. 快速生成:LRM能够在短短5秒内,从单张输入图像中生成高保真度的3D物体模型。

2. 大规模训练:与许多先前的方法不同,LRM采用了高度可扩展的基于transformer的架构,具有5亿个可学习参数,用于直接预测神经辐射场(NeRF)。

3. 数据多样性:模型以端到端的方式在包含大约100万个对象的大规模多视图数据上进行训练,包括Objaverse的合成渲染和MVIm.NET的实际捕捉数据。

4.高通用性: 由于高容量模型和大规模训练数据的结合,LRM具有很强的通用性,能够从各种测试输入中生成高质量的3D重建,包括真实世界中的野外捕捉和生成模型的图像。

5. Transformer-Based架构:LRM采用了完全可微分的transformer-based编码器-解码器框架,通过预训练的视觉模型(DINO)对输入图像进行编码,使用大型transformer解码器通过交叉注意力将图像特征投影到3D三平面表示,然后通过多层感知器预测体积渲染的点颜色和密度。

项目页面:https://yiconghong.me/LRM/