使用python来读取超大型文件数据

2019-08-30

加入收藏

在实际应用中,几乎所有的数据分析工作都是从数据读取开始的,如果数据量太大导致数据文件读取失败了,这样后续的工作就没有办法进行了,在机器自身硬件内存限制的情况下,当文件量过大的时候直接使用read等函数来进行操作的时候就会报错,这里就需要采取一定的策略来尽可能地避免这样的问题产生,今天的工作中就遇上了这样的问题,需要处理的数据文件一共是6.86GB,电脑内存是8GB的,读取的时候就报错了,用read或者readlines函数都是需要将整个文件都读进内存中去的,这样就不行了,查了一些资料,也简单总结了一下,把处理方法在这里介绍一下,具体如下:

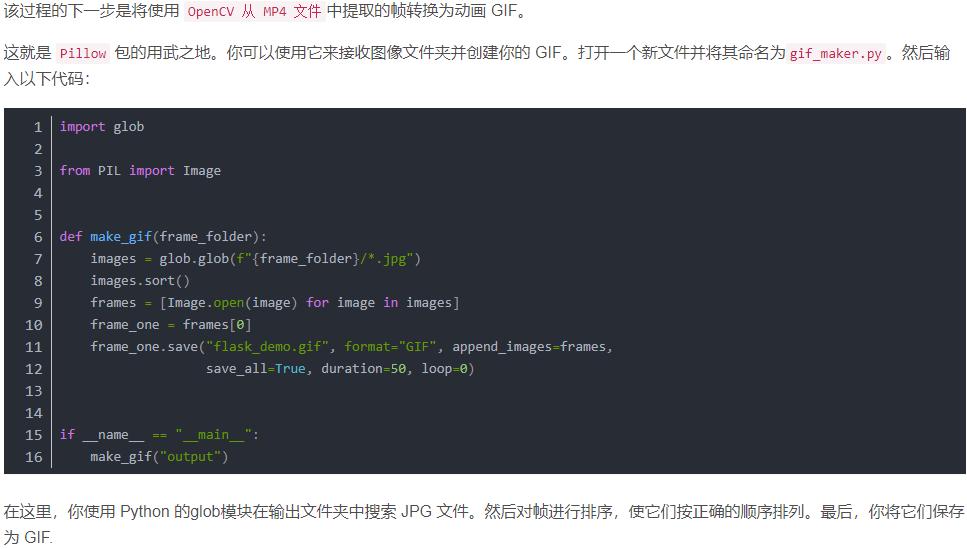

#!usr/bin/env Python #encoding:utf-8 ''' __Author__:沂水寒城 功能: 使用python来读取超大型文件 在机器自身硬件内存限制的情况下,当文件量过大的时候直接使用read等函数来进行操作的 时候就会报错,这里就需要采取一定的策略来避免这样的问题产生 ''' import linecache def readFunc1(data='test.txt'): ''' 通过指定单次读取的数据大小长度 ''' myfile=open(data) while True: block=myfile.read(1024) if not block: break else: print block myfile.close() def readFunc2(data='test.txt'): ''' 设定每次只读取一行 ''' myfile=open(data) while True: line=myfile.readline() if not line: break else: print line myfile.close() def readFunc3(data='test.txt'): ''' 利用可迭代对象file,这样会自动的使用buffered IO以及内存管理 ''' with open(data,'r') as myflie: for line in myflie: if not line: break else: print line def readFunc4(data='test.txt'): ''' 借助于第三方模块 linecache ''' #读取全部数据 all_text=linecache.getlines(data) #读取第二行数据,要注意linecache的读取索引是从1开始的,而不是从0开始的 text=linecache.getline(data, 2) print 'line 2: ',text if __name__=='__main__': readFunc1(data='test.txt') readFunc2(data='test.txt') readFunc3(data='test.txt') readFunc4(data='test.txt')

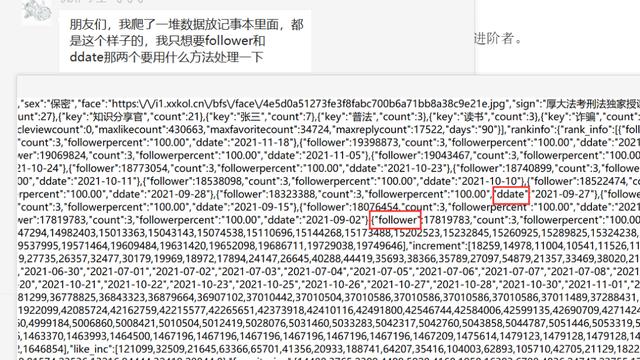

部分结果如下:

{

"11-06": {

"temperate": {

"day": {

"today_temperate": "10\u2103",

"now_temperate": "\u6c14\u6e29"

},

"three_hour": {

"11-06-23:00": "17.4\u2103",

"11-06-20:00": "18\u2103",

"11-06-17:00": "18.4\u2103",

"11-06-02:00": "20.4\u2103",

"11-06-14:00": "18.7\u2103",

"11-06-05:00": "17.9\u2103",

"11-06-11:00": "19.8\u2103",

"11-06-08:00": "17.5\u2103"

}

},

"wind_speed": {

"day": {

"today_winds": "\u5fae\u98ce",

"now_winds": "\u98ce\u5411\u98ce\u901f"

},

"three_hour": {

"11-06-23:00": "0.9\u7c73/\u79d2",

"11-06-20:00": "1.1\u7c73/\u79d2",

"11-06-17:00": "2.3\u7c73/\u79d2",

"11-06-02:00": "1.8\u7c73/\u79d2",

"11-06-14:00": "2\u7c73/\u79d2",

"11-06-05:00": "2.3\u7c73/\u79d2",

"11-06-11:00": "2.2\u7c73/\u79d2",

"11-06-08:00": "1\u7c73/\u79d2"

}

},

......

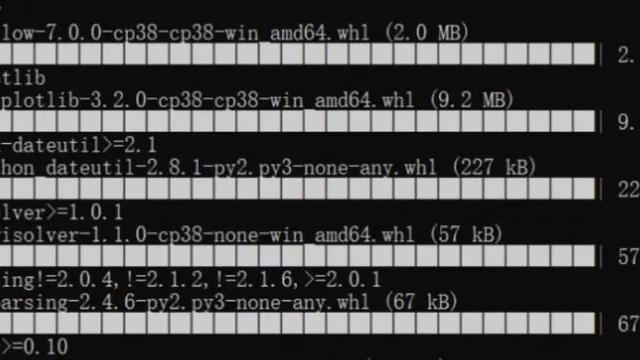

四种方法相比而言,前两种方法的核心就是化大为小,即将原始的大文件数据转化为小粒度的数据来进行读取,每次只处理单次读取的数据;第三种方法采用的是文件迭代器的方式,借助于python自带的迭代机制,自动地使用了buffered IO以及内存管理方法来解决大文件数据的读取;最后一种方法是借助于第三方的模块linecache来完成读取的,这是一个自带缓存机制的数据读取模块,最常用的方法就是上面提到的两个函数了,亲测非常好用,读取5GB的文件大概在十几秒左右的吧,直接使用pip安装的话灭有成功,我是在网上找了一个安装包完成安装的,这里放一下下载链接,如果需要的话就拿去测试使用吧,个人感觉还是很不错的。