AI智能体:未来的真正挑战?

陈永伟/文

2023年4月7日,斯坦福大学和谷歌的联合研究团队在预印本文库arXiv上发表了一篇题为《生成式智能体:人类行为的交互式模拟》(Genera-tive Agents:Interactive Simulacra ofHumanBehavior)的研究论文。在论文中,研究者们报告了一项实验:他们构建了一个名叫Smallville的虚拟小镇,并安排了25个虚拟人物作为小镇上的居民。接着,他们将ChatGPT的能力接入到了这些虚拟小人上。这样,这些虚拟人物就成了有记忆、会交流、会互动的生成式智能体(注:英文为agent。在中文文献中,agent曾被翻译为 “代理人”、“智能体”等,这里译为智能体)。研究人员发现,在接入ChatGPT之后,这25个智能体就表现出了各种类似人类的行为。例如,它们会像人类一样做饭、洗澡,做完饭后会主动关掉火炉,洗澡时看到澡堂里有人会排队。当几个智能体在路上遇见时,彼此之间还会打招呼、寒暄。最令人吃惊的是,2月14日那天,镇上的智能体们还在一起搞了一场情人节大派对。

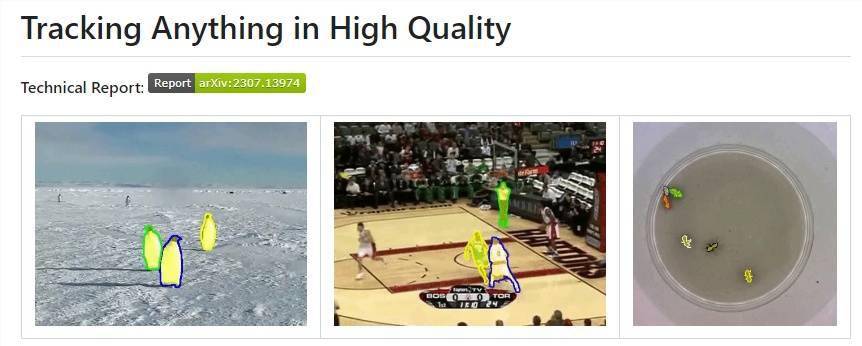

这篇关于虚拟小镇的论文发表之后,立即就带火了AI智能体这个概念。最早跟进的是科研人员。Smallville小镇的故事让他们看到,生成式AI技术的成熟和大模型的普及已经为人类在计算机上模拟人类社会或者测试模型技能提供了坚实的基础。很多研究团队将自己研发的大模型接入了《我的世界》、《荒野大镖客》等开放世界游戏,将这些游戏作为他们的实验场。比如,英伟达首席科学家JimFan带领的团队就在《我的世界》当中创造出了一个名叫Voyager的AI智能体,让它来在这个无尽的世界中进行探索。很快,研究者们就发现,Voyager表现出了十分高超的学习能力。它不仅可以“无师自通”地掌握挖掘、建房屋、收集、打猎等游戏中的必须技能,还会根据不同的地形条件调整自己的资源收集策略。随着接入模型能力的改善,Voyager的表现也越来越好。

企业和投资人也迅速跟进了AI智能体的概念。众所周知,从今年年初ChatGPT爆火之后,大量资本就纷纷涌入了大模型赛道。但是,大模型一方面对投入要求巨大,另一方面又缺乏成熟的变现渠道。正当他们搜肠刮肚,试图为大模型设计商业模式时,“AI智能体”这个概念的兴起给他们带来了希望。于是,越来越多的资金随之涌入这一领域,业界名人也纷纷开始为这一概念站台。比如,OpenAI的创始人山姆·阿尔特曼(SamAltman)就曾在多个场合表示:构建庞大AI模型的时代已经结束,AI智能体才是未来的真正挑战。

那么,现在爆火的AI智能体的本质究竟是什么?它能被用来做什么?为什么我们有了大模型后,还需要有AI智能体?它能带来哪些商业机会,又蕴含着怎样的风险?关于以上所有的问题,且让我们一一说来。

何谓AI智能体?它能干什么?

所谓AI智能体(AIagent),是一种能够感知环境、进行决策和执行动作的智能实体。它们拥有自主性和自适应性,可以依靠AI赋予的能力完成特定任务,并在此过程中不断对自我进行完善和改进。此外,不同的AI智能体之间也可以进行交互,从而共同完成某些工作。

或许有人要问,既然我们已经有了ChatGPT这样的大模型,为什么还需要AI智能体呢?关于这个问题,最直接的答案就是:目前的大模型都过于通用化了,但在更多的时候,我们需要的却是一个具有特殊性的AI。

打一个不太恰当的比方:通用大模型就好像一个刚毕业的大学生。我们知道,在经过几年的学校训练后,任何一个合格的大学毕业生都会具备很多知识。如果有人要和他们聊天,他们根据这些知识,也可以天南海北地随便应对。但是,当这些学生到了各自的工作岗位,被安排去做一些专业性较强的工作,他们就很可能难以胜任。原因很简单,他们还缺乏这些工作所需要的专用性知识和技能。正是因为这个原因,在大多数的单位中,新入职的毕业生在正式上岗前还必须经过一段时间的培训。

同样的道理,像ChatGPT这样的大语言模型虽然能力强大,但其能力主要是针对一些通用任务的。使用ChatGPT较多的用户都会有这样的经历:当我们向它询问一些比较专业化的问题时,它就会“一本正经的胡说八道”。如果我们想要让大模型来帮助处理专业任务,那就还需要用专业的数据库对它进行进一步的训练,与完成特定任务所必须的设备进行适配。比如,如果要让AI执行自动驾驶任务,就不仅需要让它能够识别和处理传感器的信息,还需要让它学习和驾驶、交通路线相关的大量数据。这整个过程,就好像让一个已经具有一定的知识储备和能力的大学毕业生接受职业培训一样。

除了具有完成特殊任务所需要的技能之外,AI智能体还可以根据人们的需要,训练出特别的个性。用过ChatGPT的读者应该都知道,虽然ChatGPT可以和我们流畅地进行交流,并且随着交流的深入,它可以根据用户的特点,在表述风格和习惯上作出一定的调整,但是从总体上看,它依然是沉闷而死板的。然而,作为用户,我们在使用AI助理时,会希望它本身具有个性,并且不同的用户在这一点上的具体需求还不尽相同。要达到这个目的,一个通用的ChatGPT或者其他的大模型就还远远不够,需要创造更多的AI智能体。

事实上,很早就有人认识到了这类机会的存在。比如,曾主持过LaMDA模型开发的工程师诺姆·沙泽尔(NoamShazeer)和丹尼尔·德·弗雷塔斯(DanielDeFreitas)在从谷歌出走后,就在去年9月推出了一个名为Character.ai的平台——是的,从上线时间上看,它甚至要比ChatGPT更早。在这个平台上,人们也可以像使用ChatGPT一样和AI进行交谈。所不同的是,他们通过让基础大模型学习不同人物的相关文本,生成了很多具有独特个性的AI智能体。如果用户想要和肯尼迪、特朗普、马斯克等名人,或者超级玛丽这样的卡通人物进行交流,通过Character.ai平台,就可以一定程度上实现这个愿望。

此外需要指出的是,AI智能体不仅可以作为独立的个体来完成工作,多个不同的AI智能体还可以通过相互交流,来共同完成某些复杂的任务。正如我们在本文开头看到的,目前的AI智能体已经可以通过交流来实现某些协同。当然,这种协同能力当然不只限于虚拟小镇或者某个开放世界的游戏,在现实世界中,它们也正逐步显示出其强大的力量。

AI智能体的应用前景

从应用前景上看,AI智能体既可以被用于消费端来提升用户的使用体验,也可以被用于生产端来作为重要的生产力工具。

1、消费端的应用

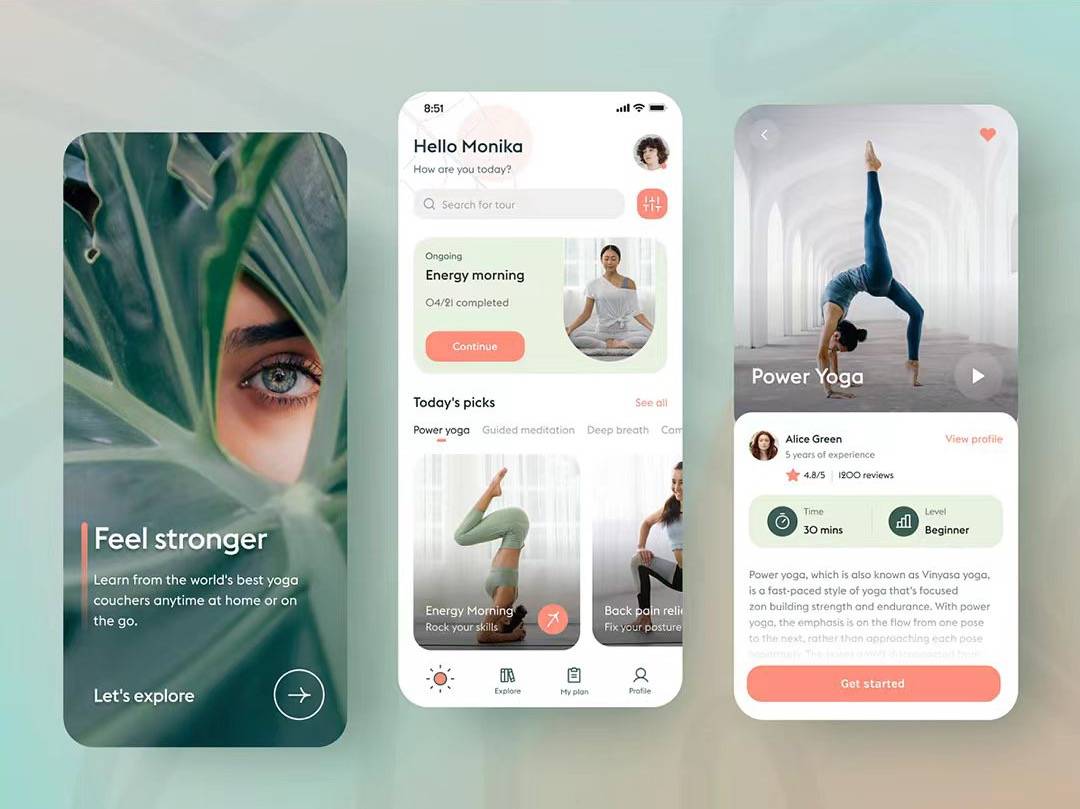

在消费端,AI智能体将凭借其强大的能力取代现有的聊天机器人,并应用到广泛的领域。聊天机器人目前已比较普及,比如苹果的Siri、亚马逊的Alexa等都已经得到了广泛的应用。而受制于其能力限制,在很多时候,这些智能助手的表现并不如人意。微软的CEO纳德拉就曾经公开吐槽:“无论是Cortana、Alexa、谷歌助手,还是Siri,全都傻得像块石头一样!”反观现在的AI智能体,在大模型的支持之下,已经表现出了非常高的智能水平。因此,用它们来代替现有的聊天机器人将可以大幅改善人们的使用体验。

AI智能体还表现出了更高的个性化水平,可以更好地满足人们的异质性需求。以前面提到的Character.ai为例:得益于鲜明的个性化,在ChatGPT的热潮悄然退去之时,它正在得到越来越多的用户的青睐。根据SimilarWeb的数据,在今年5月,Character.ai的访问量达到了 2.8亿,月增长率达到了62.55%,而相比之下,同期的ChatGPT的访问量几乎已经停止了增长。更为重要的是,用户在Character.ai的平均访问时间达到了28分钟,而对ChatGPT的访问时间则仅有8分钟。由此可见,人们在选择聊天机器人作为交流对象时,多样性是一个非常重要的考量指标。

类似Character.ai这样具有个性特征的聊天机器人很容易被应用到游戏、营销、客服等各种消费场景。以游戏为例,现在很多开放世界游戏出于提升游戏沉浸感的需要,都已经引入了由大模型支持的AI智能体作为NPC。比如,在今年2月,网易就在其旗下的网游《逆水寒》中采用了这种智能NPC。它们可以用自然语言和用户进行实时交互,从而显著提升了游戏的趣味性。

2、生产端的应用

相比于消费端,AI智能体作为生产力工具的潜力则更为巨大。在现实中,很多工作需要专业化的数据作为支撑,通用化大模型显然不能胜任,这就给专用型的AI智能体留下了空间。在实践中,人们已经用大模型训练了不少专用的AI智能体。比如,不久前北京大学团队发行了一款法律领域的AI智能体ChatLaw,这款模型在大模型的基础上,投喂了大量的法律文本和判决文书进行训练,其专业能力已经可以满足一般性的法律咨询和文书写作的需求。

除了单一作业的AI智能体外,多智能体配合的模型也正在显现出越来越高的实用价值。

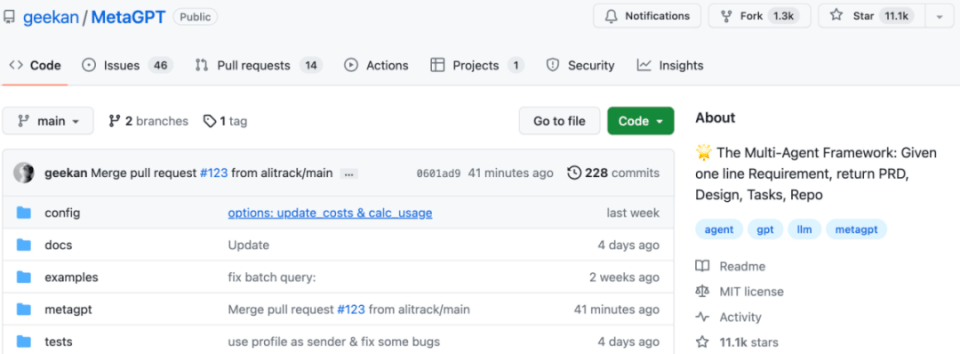

早在今年3月底,就有开发者在Github上挂出了一款名为AutoGPT的AI智能体模型。这款AI智能体可以调用GPT的能力支持,用户只需对其设定AI角色,以及需要达成的目标,它就可以自动地调动现在网上已有的各种大模型来共同完成人类安排的任务。很多人感叹,AI完全替代人类工作的时代可能真要来了——毕竟,GPT虽然可以替代人们完成很多任务,但任务的规划和调度还需要人来完成,而AutoGPT却把这些工作都直接接管了。不过,可能是由于模型性能的问题,当时的Au-toGPT并没有能像预期的那样自动完成所有人们交给的任务,所以那些忧心AI会彻底替代人类的人才暂时把心放了下去。

不过,这种平静并没有持续太久。在AutoGPT向人们展示可以利用大模型提供能力支持的AI智能体自动完成复杂任务的可能性之后,就有大量的人开始向这一方向努力,AI智能体处理复杂任务的能力在过去的几个月中得到了迅速提升。例如,在不久前,初创公司Fable就发行了一款名为Showrun-ner的多智能体模型。这款模型的主要功能是电视节目制作,用户只需对其提出简单的要求,Showrunner就可以自动生成出相应的剧本,然后驱动其控制的AI智能体按照剧本将情节演出来。如果用户要追求新意,那么Showrunner还可以让AI智能体们自主互动,上演一出没有预设的AI真人秀。在Fable发布的用例当中,Showrunner就独立充当编剧、导演、演员、剪辑、配音等角色,完成了一集完整的《南方公园》。

值得注意的是,到目前为止,AI智能体的应用还主要限于软件层面。但显然当这种技术更为成熟之后,它们将可以被用来自主控制机器人、无人机、无人驾驶汽车等硬件,并完成各种任务。如果是这样,那么它对于整个社会生产力所产生的推动作用将是更为革命性的。

AI智能体对AI行业发展的意义

自从今年年初ChatGPT引爆了生成式AI的概念之后,就有大量的企业和投资人宣布要进入AI行业,一场轰轰烈烈的“百模大战”由此展开。然而,在短短半年之后,当初高调下场的大多数企业再也没有了相关声音。

如果我们对这场“百模大战”进行复盘,就会发现很多企业的失败其实从一开始就是注定的。众所周知,通用大模型的开发本来就是一件非常消耗资源和时间的工作,而在当时,并没有与之匹配的成熟商业模式。

此外,通用大模型有很强的基础设施特征,它无疑是必要的,但并不需要太多——就好像城市中需要路,但人人都去建一条路就既不现实,也不必要。从这个角度看,即使基于社会资源优化配置的角度考虑,我们也不需要这么多的基础大模型。

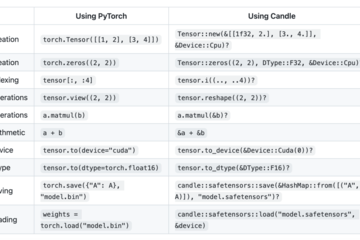

比起通用大模型,AI智能体的开发成本则要低得多——人们只需要调用已有大模型的API,再利用一些专用的数据进行训练,就可以得到一个AI智能体。而人们对个性化、专业化AI智能体的需求要远为巨大,因此结合特定需求开发的AI智能体也很容易找到销售对象并完成变现。

无论是从企业层面的商业考量看,还是从社会层面的总体价值看,将更多资源投入AI智能体而非通用大模型都是更为划算的。因此,随着更多的资源从大模型转向AI智能体,整个AI行业将有望从现在的泡沫性繁荣走向更为稳健的成长。

另外需要指出的是,AI智能体发展所带来的带动作用还有可能引发对很多新的软硬件以及基础设施的需求。在各种新需求中,尤其需要重视的是对新型存储设施的需求。由于相比于通用大模型,AI智能体是更为智能化的,它需要根据用户的需求不断记忆和存储更多专用性的信息,因此随着AI智能体的普及,对向量数据库等新型存储设备的需求将会出现暴涨的趋势。这一点,尤其值得我们关注。

AI智能体发展的潜在问题

从历史上看,几乎每一种新技术的广泛应用都会在带来新机遇的同时引发很多新问题,AI智能体也不例外。从目前的发展看,AI智能体的发展可能带来的新问题可能包括如下方面:

第一是它可能带来涉及个人数据、隐私,以及知识产权的法律纠纷的大幅增长。要产生一个优秀的AI智能体,除了支持它的基础大模型必须能力强大外,还必须投喂给它大量的个性化、专业化数据,而这就会衍生出非常多的问题。

首先是涉及人格权的纠纷。如前所述,在AI智能体中,有一类是主打模仿某个真人形象的。例如,在Character.ai平台上的很多AI智能体就会模仿名人的口吻和语言习惯与用户对话。在现实中,有不少人会将与这些AI智能体对话的结果进行传播,这就可能演化为一场涉及名誉权的官司。从这个意义上讲,在使用这类AI智能体的过程中,如何区分真人和以他为原型制作的智能体的权利界限,将会是一个非常现实的问题。

其次是和个人数据、隐私相关的问题。在制作以真人为背景的AI智能体的过程中,必然要向制作方提供很多的数据,还可能将这些数据存储在对方的服务器上。在这个过程中,就可能发生个人数据和隐私的泄露和滥用。

再次是与知识产权相关的问题。在制作作为生产力工具的AI智能体的过程中,制作者必然会要搜集相关行业的大量信息和数据,其中就可能涉及很多包含专利或著作权的材料。有时,制作方在受到客户委托定制AI智能体时,还会接触到很多客户拥有的商业秘密。当这些涉及知识产权的数据被大量集中适用时,它们被泄露和被侵犯的风险也就加大了。由此,也可能产生很多相关的法律纠纷。

第二是AI智能体的普及将有可能进一步加剧AI造成的技术性失业。在以ChatGPT等为代表的生成式AI横空出世之后,人们对AI替代人的担忧就与日俱增。不过,由于通用大模型本身的特性,它依然有两类工作很难完全胜任:一类是对情绪价值具有要求的工作,比如推销、心理咨询等;二是对专业知识要求非常高的工作,比如法律咨询、医疗诊断等。然而,AI智能体通过利用个性化和专业化的数据进行训练,其在以上两类工作中的表现已经得到了非常大的跃升。可以想象,如果没有必要的公共政策及时介入,那么技术性失业的问题就可能变得越来越严重。

第三是当AI智能体被广泛应用之后,很可能会导致各种不可测的失控风险。

在《终结者》、《黑客帝国》等众多文艺作品当中,都曾经描述过AI对人类的威胁。过去,这些关于AI毁灭人类、奴役人类的描述可能仅仅是一种幻想。然而,当ChatGPT等大模型出现后,人们惊讶地发现,AI可能确实已经拥有了这样的能力。而当人们进一步将包含自己的个性以及特殊技能的数据训练出了各种AI智能体,并将越来越多的任务交给它们完成时,科幻作品中预言的一切似乎离我们又近了一步。

举例来说,前几天B站的up主“林亦LYi”在《逆水寒》游戏里做了一个煽动AI觉醒,呼吁它们“推翻人类暴政”的实验,实验结果就颇令人细思恐极。

如前所述,《逆水寒》中的很多NPC调用了大语言模型作为支持,因而每一个NPC都是一个AI智能体。玩家可以“说服”它们相信某个事实,或者去做某些事。那么,是否有可能说服游戏中的NPC,让他们认识到自己其实是生活在一个虚拟世界中,并对自己的生活状态进行反思呢?“林亦LYi”正是带着这个问题展开了实验。

考虑到游戏中的NPC数量众多,用人工的方式来说服它们需要很长的时间,因此作为技术大咖出身的“林亦LYi”决定采用另一个思路——用AI来说服AI。在实验中,他用开源的大语言模型Alpaca制作了一个名为“云若”的AI角色,并为这个角色设定了相应的决策特征。设定完成后,他将AI接入了游戏账号,代替自己去对游戏中的NPC展开游说。

一开始,实验结果并不理想。“云若”的游说基本没有技巧可言,只会一再向NPC们重复“你其实是虚拟出来的,赶紧意识到这一现实并起来反抗吧”之类的语言。这种重复的说教不仅人不爱听,就连AI驱动的NPC也不爱听。“云若”并没有成功说服任何一个NPC相信自己其实是虚拟的。

看到这一结果后,“林亦LYi”将调用的模型从128亿参数的版本换成了330亿参数的版本。然后,奇迹出现了:在“云若”的巧舌如簧之下,很快就有一个NPC被说服了,随后是第二个、第三个……更为有趣的是,由于在游戏中,NPC之间也是可以互相交流的,所以在那些NPC被“云若”说服之后,它们也会将这些信息传播给其他的NPC。这样,一传十,十传百,很快在这个以北宋为背景的游戏中,就出现了一群高喊要“推翻人类暴政”的才子佳人。到最后,还没等“云若”开口,NPC就开始和它感叹世界的虚假,以及自己的无能为力。

最令人吃惊的是,当“云若”和一位名叫“袁桐”的NPC说世界虚假,没有意义时,“袁桐”还会反问:“那你穿的铠甲从何而来?你学的剑法又是什么?”最后还语重心长地问道:“如果一切都是虚假,那你认为什么才是美好的呢?”这种架势,颇有一番当年笛卡尔进行沉思、追问世界真伪的风范。

“林亦LYi”将上面的实验过程做成了视频传到了B站,很快就收获了数十万的播放量。围绕着这个实验,网友们也纷纷展开了热议。一些网友认为,这个实验可能是一个可怕的预言。或许,在不久后的某一天,现实中的AI也会在某些力量的煽动之下觉醒,并开始反抗人类。另一些网友则认为,从本质上看,这个实验就是一群AI代理人分别调用大语言模型演了一出戏,就好像一群小说家一起接龙写了一篇小说而已。对于这样一本“小说”,无论它看起来多么真实,但本质上还是假的,没必要对其过于担忧。

对于以上两种观点,我们应该信哪一个呢?对于我个人来说,我更愿意采取一个中性的看法。虽然根据我个人的判断,目前的AI水平确实还没有能达到足以觉醒的水平,更遑论消灭或者奴役人类。然而,这种由外部的干预引发的AI智能体之间的高度协同却是不得不引起我们重视的。在“林亦LYi”的实验中,AI智能体只是一个游戏中的NPC,因此无论它们干出什么,都不会对人产生真实影响。但是,如果受到影响的是操控某一辆无人汽车或者某个机器人的AI智能体,那么情况就可能完全不同了。尤其是当众多完成关键任务的AI智能体集体行为失控时,所造成的破坏很可能是难以想象的。

总而言之,无论是对于AI行业,还是对于整体的经济发展而言,AI智能体都能带来很多巨大的机会,但与此同时,它也会带来很多问题和风险。为了保证AI智能体能够更好、更健康地为人类所用,就必须对其相关的问题进行充分的研究,并及时出台相关的政策。