自然语言处理(NaturalLanguage Processing,NLP)是人工智能领域的重要分支,致力于使计算机能够理解和处理人类语言。然而,由于不同领域的文本数据具有特定的语义和结构特征,传统的NLP模型往往在面对新的领域任务时遇到挑战。为了克服这一问题,近年来,基于迁移学习的NLP模型逐渐引起研究者的关注。本文将介绍基于迁移学习的NLP模型的原理、方法和应用,并展望其未来的发展。

一、迁移学习简介

迁移学习是一种通过将已学习的知识迁移到新任务或领域中来提升模型性能的方法。在自然语言处理领域,迁移学习可以通过利用预训练的语言模型,将其知识和表示能力迁移到新的任务或领域中,从而加速模型的训练和提高性能。

二、基于迁移学习的自然语言处理模型原理

基于迁移学习的NLP模型通常包含以下几个关键步骤:

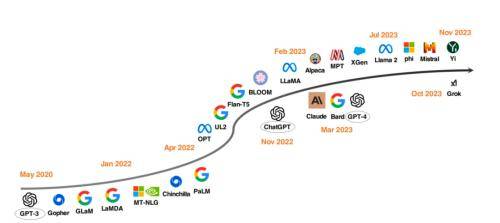

预训练模型:利用大规模的文本语料进行预训练,学习得到通用的语言模型。如BERT、GPT等都是常见的预训练模型。

微调模型:将预训练模型应用于特定任务或领域,通过在少量标注数据上进行微调,使其适应新任务或领域的特定语义和结构。

特征提取:利用预训练模型的中间层输出或注意力机制等方法,提取文本的抽象语义特征,将文本转化为机器可理解的表示形式。

任务训练:在特定任务的标注数据上对模型进行训练,通过最小化损失函数来优化模型参数,使其达到最佳性能。

三、基于迁移学习的自然语言处理模型应用

文本分类:通过将预训练的语言模型应用于文本分类任务,可以有效提取文本中的关键信息,实现准确的分类。

命名实体识别:利用预训练模型的语义表示能力,可以更好地捕捉命名实体的上下文信息,提高命名实体识别的准确性。

情感分析:通过迁移学习,可以在情感分析任务中利用大规模的无标注数据进行预训练,从而提升模型对情感表达的理解能力。

机器翻译:将预训练模型应用于机器翻译任务中,可以提取源语言和目标语言之间的语义对应关系,改善翻译质量。

综上所述,基于迁移学习的自然语言处理模型为解决不同领域文本处理问题提供了一种有效的方法。它不仅能够充分利用大规模的无标注数据进行预训练,还能够将通用的语言表示能力迁移到新任务或领域中,从而提高模型的泛化能力和性能。然而,在实际应用中,仍然存在一些挑战和问题,如领域适应性、数据偏差等。

未来,我们可以进一步研究和改进基于迁移学习的NLP模型,探索更好的迁移策略和算法,以应对多样化的文本处理需求,并推动NLP技术的发展,实现更加智能和高效的自然语言处理应用。