人工智能的第一性原理是什么?

来源:清湛人工智能研究院

作者:郭平

这篇文章是郭平教授的一篇文章,本文采用“四问”的表述方式,解释了人工智能的第一性原理。提出了在基于物理的人工智能基础研究领域,运用第一性原理思维解决人工智能缺乏基础自然科学常识的一种思路;并建议将最小作用量原理作为人工智能的第一性原理。

实现通用人工智能(Artificial General Intelligence,AGI)是一个长远目标。我们需要探索通往人工智能(AI)的道路,要以基础研究作为出发点。“基础研究是整个科学体系的源头,是所有技术问题的总机关。”这也说明了AI基础理论研究的意义和重要性。要加强AI的数学物理基础研究,可以将“第一性原理”(first principle)作为出发点,发展新一代AI基础理论。

人工智能领域存在第一性原理吗?

古希腊哲学家亚里士多德将第一性原理(或首要原则)表述为:“在每一个系统的探索中,存在第一性原理,这是一个最基本的命题或假设,不能被省略或删除,也不能被违反。” 在20世纪以前,第一性原理主要用于哲学、数学和理论物理。在数学中,第一性原理是一个或几个公理,且不能从系统内的任何其他公理中推导出来。在理论物理中,第一性原理是指一个计算直接从物理定律建立,不做经验模型和拟合参数等假设。生物学的第一性原理是达尔文提出的“物竞天择、适者生存”理论。在近代社会,第一性原理已经扩展到许多学科,包括生命科学、化学、经济、社会科学等。

随着人类认知的发展,第一性原理已经从最初的哲学术语分化为专业性更强的表述,有些已不再使用“第一性原理”这个术语,而采用其同义词表述。在哲学中采用了“先验原理”(priori-principle),数学中统一使用了规范术语“公理”(axioms),而物理学则沿用了“第一性原理”。

AI领域是否存在第一性原理,是个有争议的话题。有人认为AI不存在第一性原理,理由是第一性原理是在哲学、数学或物理规则定义的域内定义了问题空间的边界,而AI领域的第一性原理需要在明确定义了什么是“智能”之后才有意义。

目前对“智能”还没有明确定义,因此对AI还没有一个精确的、人们普遍可以接受的定义。在学界有两个定义可参考:一是斯坦福大学人工智能研究中心尼尔斯·约翰·尼尔逊(Nils J. Nilsson)教授提出的“AI是关于知识的学科——怎样表示知识、怎样获得知识并使用知识的科学。” 二是麻省理工学院的帕特里克·温斯顿(Patrick Winston)教授提出的 “AI就是研究如何使计算机去做过去只有人类能做的智能工作”。

有人认为AI没有第一性原理,依据是尼尔逊教授撰写的《人工智能原理》(Principles of Artificial Intelligence)一书[1]。在该书的第2页,有一段话给我们明确呈现出这样的概念:“AI目前没有通用理论,因此接下来向您展示一些应用程序。”也就是说,目前AI不存在第一性原理,现在应把注意力放在与工程目标相关的原理上,这些原理是衍生出来的原理。衍生的原理实际上告诉我们复杂系统的一些简单结果,无论是自然还是AI,其本质可能也是如此。智能是许多过程并行发生和相互作用的结果,而这些过程无法轻易地追溯到一个基本的物理原理。

我们认为这是把AI看作是一种技术,从技术的角度看问题,也就是说,把AI看作类似于建立在实验基础上的学科。

物理学家张首晟在一次演讲时提到了第一性原理的思维方式:在20世纪以前,第一性原理的概念属于人脑的归纳、演绎产生的逻辑自洽学科,包括数学、哲学和理论物理,其理论体系的基石都可称之为第一性原理。它们可以明显区别于诸如化学、生物等建立在实验基础上的学科。

在21世纪的今天,人们的认知水平与科学技术发生了很大的变化。在以实验为基础的学科上,均有基于第一性原理的成果。例如在生物科学方面,第一性原理也被重新发掘出来。最近,美国圣塔菲研究所(Santa Fe Institute)现任所长戴维·克拉考尔(David Krakauer)在《理论生物科学》(Theory BIOScience)期刊发表了一篇题为“个体信息理论”的文章,基于第一性原理的数学形式化理论,通过捕捉从过去到未来的信息流,能够严格定义许多不同形式的个体。但也有人提出了质疑:“作者试图给出‘从头计算’生命的一般框架,野心是很大的。但其给出一个调节参数γ,就不能不让人怀疑其‘科学立场’了。”

对一种观点有不同的看法是很正常的。目前大家公认的看法是,以深度学习为主导的AI没有理论。但实现AI是以计算机技术为基础的,计算机也是先有技术,后发展科学理论的。ACM图灵奖获得者雅恩·乐昆(Yann LeCun)认为理论往往是在发明之后构建起来的,例如蒸汽机的发明在热力学之前,可编程计算机在计算机科学之前,等等。有了理论基础,即使只是概念上的基础,也将大大加快该领域的研究进展。

尼尔逊教授的《人工智能原理》一书已经出版了40余年,如今AI理论仍在发展,我们的思维认知水平也提高了,因此现在应该重新考虑AI是否存在第一性原理这个问题了。李国杰院士认为,AI与计算机科学在本质上是一门学科。AI系统就是用计算机技术对信息加工和处理的系统。既然是一个系统,那么依据定义,每一个系统中都应该存在第一性原理。

我们知道,机器学习是AI的一个子集,AI基础研究是建立在数学和物理基础之上的。北京交通大学教授于剑出版了一本书《机器学习:从公理到算法》。这是一本基于公理研究学习算法的书,实际上就是把数学的第一性原理应用于机器学习,只是没有显式地表述出来而已。于剑教授的这本书可谓将第一性原理应用于机器学习的范例。

由于物理是基础科学,许多学科是以物理为基础的,物理的第一性原理就可以应用到这些学科。物理的第一性原理也被称为“从头计算”(ab initio),即只使用最基本的物理学定律,不使用经验参数,仅用电子质量、光速、质子、中子质量等少数实验数据去做量子计算。我们研究基于物理的AI,AI的第一性原理可以借用物理的第一性原理,将“从头计算”应用到AI,可以视为AI的第一性原理。但是“从头计算”是狭义的第一性原理,广义的第一性原理是“最小作用量原理”(the least action principle)。

为什么是基于物理的人工智能?

数学、物理不但是其他学科的基础,更是AI的基础。为什么要基于物理学研究AI基础理论?这是因为物理学是研究物质运动最一般规律和物质基本结构的学科,是自然科学的带头学科,其他各自然科学学科的研究基础都建立在物理学科之上,而且哲学与物理的关系也非常紧密。著名物理学家斯蒂芬·霍金(Stephen Hawking)在他的论著《大设计》(The Grand Design)第一页上就语出惊人地宣称“哲学已死”,因为“哲学跟不上科学,特别是物理学现代发展的步伐。在我们探索知识的旅程中,科学家已成为火炬手。” 虽然这是一个被人批评为极为傲慢的“宣言”,但也从中说明物理学促进了哲学的发展。

雅恩·乐昆在IJCAI 2018(国际人工智能联合会议)的演讲中指出了目前AI系统的几个缺点:缺乏独立于任务的背景知识,缺乏常识,缺乏预测行为后果的能力,缺乏长期规划和推理的能力。简言之就是没有世界模型,没有关于世界运行的通用背景知识,我们需要学习一个具备常识推理与预测能力的世界模型。因此,未来关于AI的研究需要形成一种新型的理论,该理论的目标是构建可以实现的世界模型。也有学者认为,为了更好地描述神经网络和神经系统,我们需要一套新的数学语言和框架,但这个新的框架究竟在哪里,目前学术界还没有统一的思路和共识。我们认为基于物理的AI可能是最有希望实现的一个新框架。

对于AI缺乏常识的问题,基于物理的AI框架可能会提供一种解决思路。要想将常识赋予AI,首先需要搞清楚什么是常识。通俗地讲,常识就是大部分人都知道的普通知识。按照网络百科的描述,普通知识就是一个生活在社会中的心智健全的人所应该具备的基本知识,包括生存技能(生活自理能力)、基本劳作技能、基础的自然科学以及人文社会科学知识等。关于常识的一种较为专业的释义是:一般指从事各项工作以及进行学术研究所需具备的相关领域内的基础知识。而这些基础知识来源于对自然规律、自然现象或者人类社会活动的归纳总结。

如何让人工智能具有常识?

雅恩·乐昆解释过AI为什么没有常识:“我们没有能力让机器去学习庞大的背景知识,而婴儿在出生以后的最初几个月里就可获得关于这个世界的庞大的背景知识。”这就是说,AI要掌握常识,需要搞清楚物理世界的运作方式并做出合理决定,它们必须能够获取大量的背景知识、了解世界的运行规律,进而做出准确的预测和计划。不难看出,本质上这是归纳性的思维方式。而我们的常识,大多数是运用归纳法获得的。

为什么让AI具有常识这么难?数十年来,该研究一直进展甚微,可能的原因之一是没有按照第一性原理思考。一提到AI没有常识,从大多数学者举的例子来看,他们潜意识地认为AI的常识包括了所有领域的基础知识。其实,常识是领域相关的,有生活常识、基本劳作技能,还有基础的自然科学常识等。如果上来就想赋予AI具有所有的、没有分类的常识,不考虑常识的领域相关性,这显然是按AGI要求的。但是主流AI学界目前的努力从来就不是朝着AGI方向的,现有技术的发展也不会自动地使AGI成为可能。目前可以实现的都是在考虑某种特定类型的智能行为,也就是所谓的“弱人工智能”。实际上,我们完全有理由认为,采用类比思维,即使能精确地观察和仿制出神经细胞的行为,也无法还原产生出智能行为。因此,依据第一性原理思维,在复杂的现象中找到最根本的原理,才能解决根本的问题。按照第一性原理思维,需要从头计算,即先训练AI,学习基础的自然科学常识。这也就是新加坡国立大学教授颜水成所提出的婴儿学习(baby learning)方法,即模拟婴儿自学习逐步获取知识的方法。

为了让AI拥有常识,我们需要化繁为简,把常识限定到特定的领域,例如将掌握物理科学常识作为现阶段的首要目标。用第一性原理的思维方式,把基于物理的科学常识灌输给AI。因此,我们需要转变一下思维方式,从纯数据处理逻辑迈向某种形式的“常识”,即从基本物理原理出发,让AI先掌握科学常识,从而学习推理。

为什么先让AI学习基础的自然科学常识,而不是生活常识或其他领域的常识呢?基础的自然科学常识背后的物理原理是有明确定义的,且可以由数学公式描述的。第一性原理是通过少数的几个公理演绎出事物目前的状态,而物理的定律往往是用偏微分方程来描述的。牛顿的一部《自然哲学的数学原理》为经典力学定义了一套基本概念,提出了力学的三大定律和万有引力定律,从而使经典力学成为一个完整的理论体系。从物理定律出发,用牛顿力学的公式演绎出各种运动现象,至少能使AI具有用经典力学可以解释的自然现象的科学常识。

实际上在这方面已经有了先例。AAAI 2017的最佳论文《基于物理和领域知识的神经网络无标签监督》,就是基于万有引力定律推算出枕头的运动轨迹,利用网络的输出必须满足物理定律的约束来训练神经网络,从而实现了神经网络的无标签监督学习。这里面的常识就是:一个物体如果没有其他外力作用,例如桌面的支撑力,则在万有引力作用下做自由落体运动。而我们的IJCNN 2017论文,本质上也是基于惠更斯-菲涅尔成像原理,实现了对光谱图像校正的神经网络无标签监督学习。

基于第一性原理思维需要花费更多的精力,而基于第一性原理构建世界模型要比模仿计算可能需要更大的计算量。一方面,目前我们还没有足够的算力让机器去学习庞大的背景知识,但只限定于基础的自然科学的背景知识还是有可能的。最近有文献表明GPT-3(OpenAI于2020年5月发布的Generative Pre-training Transformer语言模型第3版)具有1750亿个参数,所使用的数据集容量达到了45TB,说明目前的算力已经有了很大的提高。另一方面是运用物理思维做合理的近似,简化问题复杂度,把不可计算的问题约减为可计算的问题。例如基于平均场理论,把多体问题近似为两体问题。数学家总是想精确求解问题,而物理学家会在无法精确求解的情况下采用近似方法。因此有人戏称数学家总爱把简单的问题复杂化,而物理学家则尽力把复杂的问题简单化。如果说为什么要研究基于物理的AI,这也算得上是一条理由吧。

追求和谐、统一与完美是物理学家的最高境界,这也是AI科学家以及所有科学家追求的境界。AI的第一性原理也应该是对完美追求的典范。物理学中的最小作用量原理就是一个非常简单而优雅的原理,可看作是整个物理学的第一性原理。该原理是现代物理学和数学的核心,在热力学、流体力学、相对论、量子力学、粒子物理学和弦理论都有广泛的应用。对最小作用量原理更详细的介绍请参考文献,物理学家理查德·费曼(Richard Feynman)对此有非常精彩的讲解,本文不再赘述。在具体实现上,从具有可操作性的角度考虑,我们认为应该将最小作用量原理作为AI的第一性原理,期望能在最小作用量原理这块基石上,建立基于物理的AI宏伟大厦。

为什么要用和如何应用第一性原理?

近几百年来,哥白尼、牛顿、爱因斯坦、达尔文等科学巨匠对科学革命做出了巨大的贡献。而科学革命带来的技术进步,促进了社会生产力快速发展和社会文化进步,对人类文明产生了巨大影响。他们共同的思维方式,都是简洁而优美的第一性原理。爱因斯坦说过:“适用于科学幼年时代的以归纳为主的方法,正在让位于探索性的演绎法”,应该“由经验材料作为引导,研究者宁愿提出一种思想体系,它一般是在逻辑上从少数几个所谓公理的基本假定建立起来的”。这段话不但告诉我们其科研方法是第一性原理思维,还告诉我们要使用演绎法。第一性原理的本质是逻辑学中的演绎性思维。

我们知道,深度学习是机器学习的一个子集,而机器学习是人工智能的一个子集,其局限之一在于无法解释因果关系。因果关系是一个事件和另一个事件之间的作用关系,其中前一个事件是原因,后一事件被认为是前一事件的结果。一般来说,一个事件可能是很多发生在较早时间点的原因综合产生的结果,而该事件又可以成为发生在之后时间点的其他事件的原因。因果关系亦称“因果律”,哲学上有一种对第一性原理的说法:“第一性原理是超越因果律的第一因,且是唯一因,同时第一性原理一定是抽象的。” 第一性原理思维显然与因果关系紧密相连,这或许为我们解决AI无法解释因果关系的问题提供了一种新的思路。

由于思维逻辑和观察视角直接影响对问题的理解,基于第一性原理思维无疑会有助于深刻理解问题。第一性原理应用在企业获得成功的典范人物是“钢铁侠”埃隆·马斯克(Elon Musk)。在一次TED采访中,他告诉大家他成功的秘密是运用了第一性原理思维。我们可以理解为第一性原理的思维方式是用物理学的角度看待世界,一层层拨开事物表象,看到里面的本质,再从本质一层层往上走。马斯克的第一性原理思维方式在企业界引起了轰动,带动了企业家依据第一性原理思考问题去进行颠覆式创新。

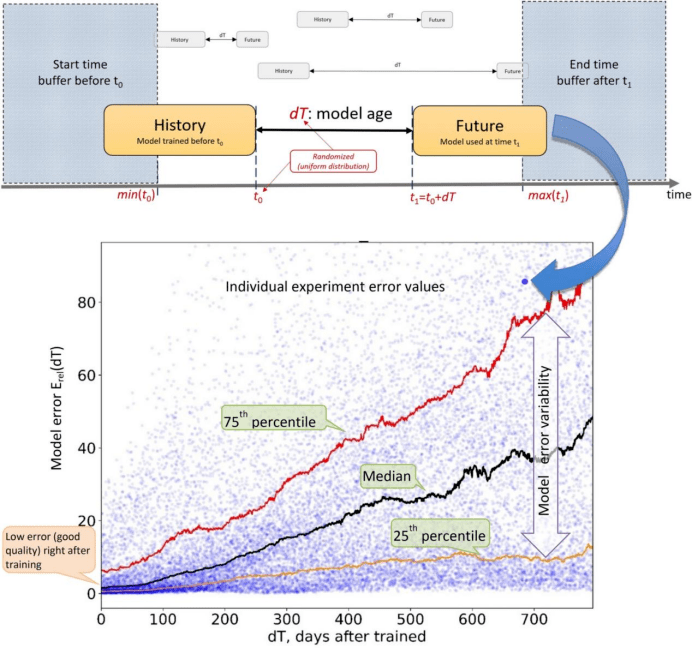

在AI基础研究领域,基于第一性原理构建世界模型是一个科学问题。而在自然语言处理(NLP)领域,能在50多种任务上取得惊艳效果的GPT-3模型,只是证明了现有技术的可扩展性,不可能走向AGI。从文献和报道来看,GPT-3的基础架构并没有太大变化,仍然是基于大数据(使用45TB数据进行训练)、大模型(拥有 1750亿个参数)、大算力(拥有超过 285000 个 CPU 内核、10000 个 GPU 的超级计算机和 400Gbps 的网络连接)这三种要素的神经网络AI。在关于GPT-3的论文中也说明了数据越大,参数量越大,模型的性能表现越好的观点得到了验证。论文中也暗示了AI中仅仅增加算力的局限性,算法设计方面没有突破。

尽管 GPT-3表现出了巨大的潜力,但基于深度学习的AI仍然存在问题,包括存在偏见、依赖于预训练数据、不具有常识、没有基于因果关系的推理能力、缺乏可解释性等。GPT-3不可能理解人们赋予它的任务,也无法判断命题是否有意义。凯文·拉克的博客展示了对GPT-3的图灵测试。测试中有个问题是:“我的脚有多少只眼睛?” GPT-3答:“你的脚有两只眼睛。”当一个句子中涉及的物体超过两个时,GPT-3体现出短时记忆有限的缺陷,不会举一反三,推理出现困难。

第一性原理思维是一种演绎性思维方式,是要坚持不懈地追求问题的本质,然后用追本溯源得到的这些基础知识来解决问题。我们基于第一性原理思维,从宏观、介观到微观三个层次全方位来分析一下GPT-3系统。一个AI系统从宏观上看是由软件和硬件组成的系统,软件是AI系统的灵魂,硬件是物理实体。从硬件角度来看,GPT-3所用的计算机仍然是冯·诺伊曼体系结构:计算机的数制采用二进制,计算机按照人的指令编写好的程序顺序执行。之所以采用二进制,是因为在用半导体材料制成的元器件中,用高电平表示1,低电平表示0。从基本的元器件构成运算器、存储器,再到集成电路,直至现代的超级计算机,均是人设计并制造出来的。计算机指令采用二进制编码,有确定性的机器指令集。目前计算机所产生的随机数也是伪随机数,不可能像高等智慧生物那样自主产生意识。现有的AI芯片,也只是把人们设计的算法硬件化,AI的核心算法并没有得到突破,硬件化后只是对现有的算法加速了,并没有开发出真正的智能芯片。从软件的角度来看,软件是计算机程序+文档及数据,程序包含了算法。在AI算法上,GPT-3采用了与GPT-2同样的Transformer架构,不同之处是它融合了一种稀疏自注意力机制。利用自注意力机制有效提高了训练速度,改善了循环神经网络(RNN)学习速度慢的缺点。因此,在冯·诺伊曼体系结构与目前深度学习算法下,依据“无限猴子定理”,需要无限长时间才有可能完成一部《红楼梦》,在有限时间内能让GPT-3产生一部类似《红楼梦》的著作的概率也是无限小。即使产生了一部人们可以读懂的著作,但GPT-3也完全不可理解其内容是什么含义。所以在当前的架构下,GPT-3不会迈向AGI,不会像有些人说的是“硅基文明的崛起”。这就是基于第一性原理思维得出的结论。

在《MIT技术评论》(Technology Review)杂志中的一篇文章1评论到,OpenAI的新语言生成器GPT-3是“令人震惊的好”和“完全没有头脑”。至于未来GPT-3是否会迈向AGI,技术新闻网站The Verge的报道2给出了这样一段话:“这种按规模改进的概念非常重要,它正好是关于AI未来的一场大辩论的核心:我们究竟是使用当前的工具来构建AGI,还是需要进行新的基础发现?AI从业者对此尚未达成共识,仍存在大量争论。这些主要可划分成两大阵营。一个阵营争辩说,我们缺少创造人工智慧的关键组成部分,即计算机必须先了解因果关系等事物,然后才能接近人类的智能。另一个阵营则说,如果该领域的历史能够表明了什么的话,那么实际上AI的问题基本是可以通过向它们投入更多的数据和提高计算机的处理能力来解决的。”

OpenAI公司属于后一阵营,他们一直认为巨大的计算力配合强化学习,是通往AGI必经之路。但是大多数AI学者,包括ACM图灵奖获得者约书亚·本吉奥(Yoshua Bengio)和雅恩·乐昆,基本上是属于前一阵营的,认为AGI是不可能创造出来的。从第一性原理出发,我们得到的结论是不可能实现AGI。对此,我们应有非常清醒的认知:受物理规律的制约,深度学习框架的天花板很快就会来临。如果在基础理论方面没有突破,基于深度学习的框架就不可能发展成为硅基文明的AGI。所谓的硅基文明是科学幻想,不是科学事实。GPT-3没有产生技术革命,只是在应用上取得了重大突破。未来我们仍有很多问题有待解决,还需要从第一性原理出发,重新构建AI基础理论框架,才能赋予AI常识,发展具有可解释性的AI。

结束语

正如清华大学张钹院士所说,在探索通往AGI的道路上,“现在走得并不远,在出发点附近”。毛泽东主席说过,“路线是个纲,纲举目张”,“人多,枪多,代替不了正确的路线”。即使AI从业人员多,算力也很强大,但如果路线不正确,我们就有可能走很多弯路,甚至会陷入局部极值的坑里出不来。在AI基础研究领域,正确的路线之一也许是摒弃类比思维,采用第一性原理的思维方式。

期望我们能以第一性原理为出发点,能在不远的将来实现一个小目标,即先让AI具有基于物理规律的科学常识,让人工智能不再是“人工智障”。本文也希望抛砖引玉,在演绎性思维模式下创新,在AI基础理论上有颠覆性突破。

郭平教授,北京师范大学图象处理研究中心主任,计算机科学与技术系主任,1983年毕业于北京大学物理系,获硕士学位,2001年毕业于香港中文大学计算机科学与工程系,获博士学位。1993-1994在美国莱特州立大学计算机科学与工程系访问。2000年5月-2000年8月在中科院自动化所模式识别国家重点实验室访问。

来源:清湛人工智能研究院

作者:郭平

声明:本文版权归原作者及原出处所有,内容为作者观点,并不代表本公众号赞同其观点及对其真实性负责。如涉及版权等问题,请及时与我们联系,我们立即更正或删除相关内容。本公众号拥有对此声明的最终解释权。