一张图片产生五感的AI模型,究竟如何做到的?

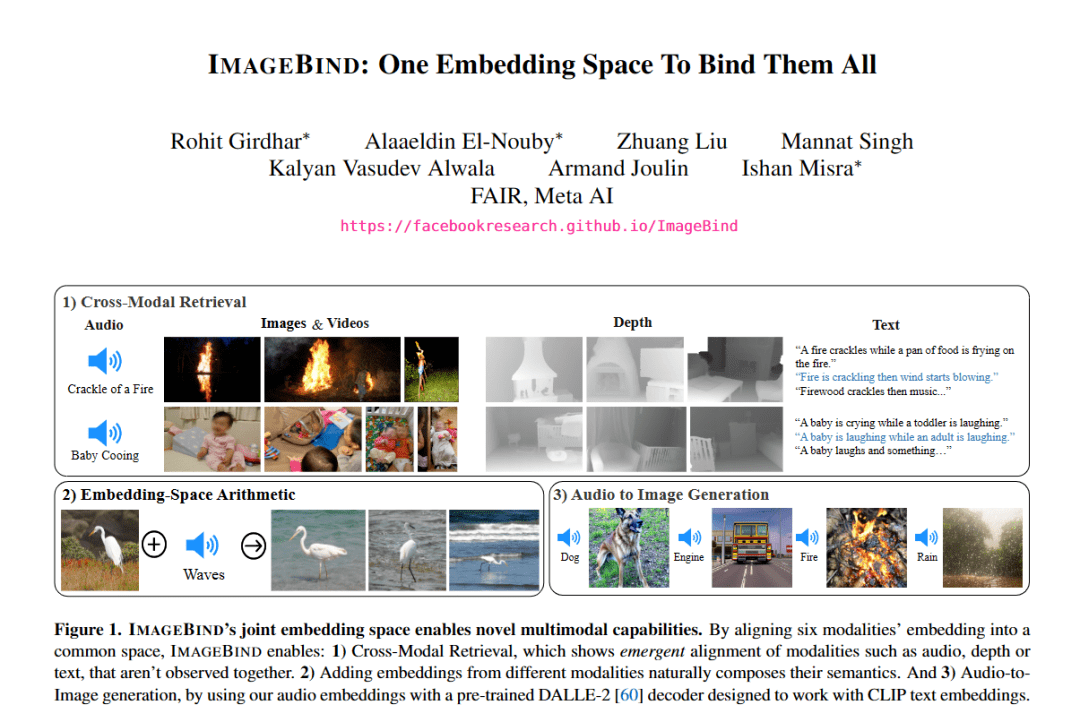

最近,MetAImage在技术圈引起了极大的好评。在《IMAGEBIND:One Embedding Space To Bind Them All》的论文中,通过一个嵌入空间,Meta 的 ImageBind 将五种不同的模态与图像进行连接配对,非常精彩。

1、“跨五感”的模型问世

比如,给你看一张海滩的图片,你就会联想到海浪的声音、咸味的空气和你周围的热浪,反过来,如果你听到打鼾,你可以想象一个人躺着进入深度睡眠中的画面。

这的确也很符合常识:人类可以根据图像想象出气味、声音以及空间的感觉,反之亦然。

那么 AI 能像人类一样将许多不同且不相关的模式绑定在一起吗?Meta AI发表的ImageBind论文就是解决了这个问题。

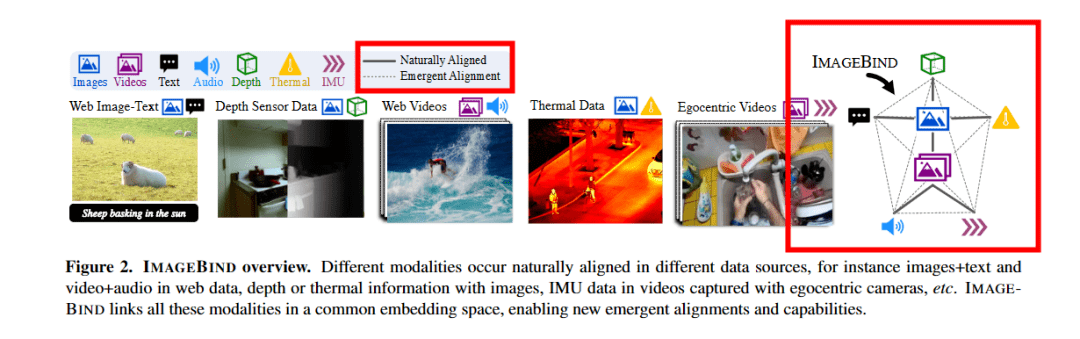

为了“绑定”多种模式,而不仅仅是文本和图像,该论文的研究人员将图像作为主要数据,并测试了音频、热图(热像仪)、文本和 IMU(惯性测量,一系列加速度计、陀螺仪等)和深度。

为了将深度和文本等两种不相关的模式联系起来,研究人员使用了对比学习(Contrastive Learning)。将图像数据作为主要要求,论文中显示了代表任何给定数据中可用的图像实际链接的粗实线。

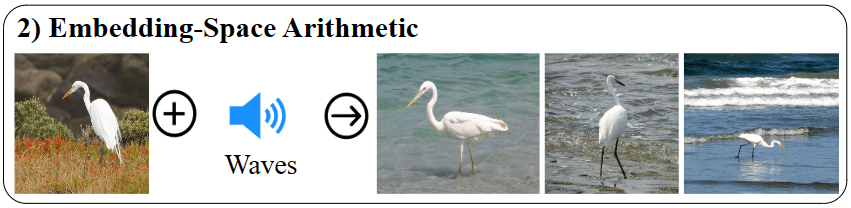

接下来,研究人员展示了紧急链接是如何发生的,现在您可以获取音频和文本数据点并获得正确的图像或视频。这种能力以前并不存在;这是新兴(emergent Link)的。使用成对的对齐观察值(例如吠叫声和文本“狗”),它可以正确地将输出提供一张狗的图像。论文中给出的另一个例子是鹳的图像和海浪的声音结合了模态,并显示了鹳在水中的图像。

这篇论文的基础在于,人们实际上并不需要数据对与图像连接在一起。例如,只需将深度或热图信息与文本(具有与图像的实际联结)配对,用户就可以创建包含所有这三个信息的图像。该论文将这种现象称为“快速对齐(emergent alignment)”。

2、为什么不采用 Meta 的数据集

Meta 的 Facebook 拥有最大的图像和文本配对数据集之一。奇怪的是,研究人员没有使用他们自己的数据集,而是使用了 OpenAI 的CLIP数据集,然而,可能使用Meta自己在过去十年中收集的数据集来训练这个模型本应该是有意义的。另一方面,没有任何 GPT-4多模式架构的迹象。

但机器人研究员 Hugo Ponte 却不觉得这样,并认为 Meta 使用 CLIP 是一个明智之举。

首先,CLIP 是一个为图像和语言创建共享嵌入空间的模型,非常强大。在 CLIP 数据集上添加 ImageBind 使得该模型不仅适用于文本,而且几乎适用于论文中提到的所有其他模式。如果用户有音频、IMU、热图、深度和文本数据,开发者可以创建最接近该数据的图像。

Ponte 进一步分析了这篇论文和作者选择 CLIP 的原因——“我认为这是一个明智之举,这样,他们没有改变 CLIP 嵌入空间,这意味着你实际上可以返回到过去三年里发布的每一篇使用 CLIP 的论文,并可以直接插入 ImageBind 来替代使用。”

通过使用 ImageBind,我们可以将任何内容投射到 CLIP 中。“他们没有取代CLIP,而是扩展了 CLIP,这让它变得更好,因为 CLIP 也适用于对比学习,需要图像和图像显示的文本的配对示例。”Ponte 补充道。

此外,ImageBind 作者还采用了 Vision Transformer (ViT),这是一种当今常见的架构,可以为不同模式的相关概念创建类似的嵌入,例如将“狗”与狗的图像相关联。

3、下一步是什么

不出所料,Meta 也开源了代码,但有趣的是也给商业目的戴上了紧箍咒,不允许商用。然而,开发人员已经使用 ImageBind 构建了一个巧妙的搜索引擎演示。搜索引擎使用文本、音频甚至视觉输入检索人工智能生成的图像。

Meta AI 负责人 Yann LeCun 表示,该模型没有公开发布可能是出于法律原因,也可能是因为它只是第一篇具有如此广泛模式的论文。这减缓了该论文的采用速度,仅在其上开发了几个演示。

然而,广泛的模式看起来像是向 Yann Lecun 的AGI 方法迈出的一步。到目前为止,该模型可以从不同的“感官”中学习,以生成模仿人类如何感知世界的正确图像。