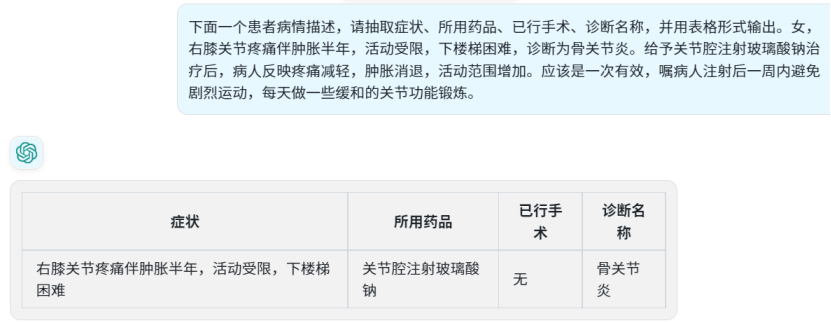

AIGC大肆污染互联网,防范垃圾内容要“用魔法打败魔法”?

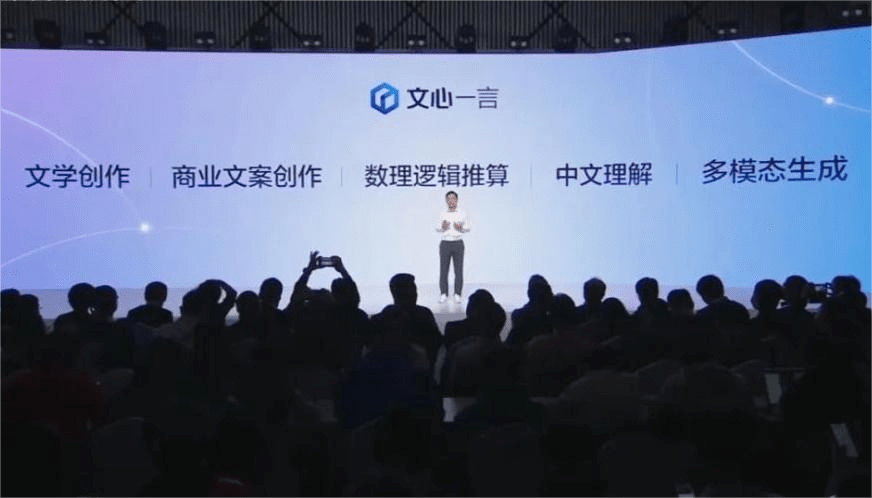

2 月初,随着 ChatGPT 和微软 Bing AI 接连引爆互联网,ChatGPT 概念股应声而起,其中知乎因为大量问答被广泛地用于生成式 AI 的训练,股价一度暴涨 31%,之后百度文心一言发布时又涨了一大波。

但到了 4 月,一位网友就在知名程序员社区 V2ex 发帖感慨:「ChatGPT 会是知乎最大的敌人。」

不仅是他,很多人都发现知乎已经充斥了大量 AI 生成的回答,有些可能是无关痛痒的观点,但不少也出现了「一本正经胡说八道」。与此同时,AI 生成内容也在一步一步扩大自己的「领土」,从互联网延伸真实世界。

海外技术社区 Hacker News 上有人指出,一家网红营销机构网站上的一篇博文出现了「抱歉,作为一种 AI 语言模型,我无法预测未来的事件或趋势」的提醒,类似的话语还出现在卡塔尔的购物中心目录和芬兰的一家电子产品商店的网站等地方。

更多 AI 生成的虚假内容,或许还没有被发现。

没人想要一个虚假的世界

图/AI生成

很多人可能还记得,今年 3 月网上流传出一系列「特朗普被捕」的照片,虽然后续大量报道都指出其为 AI 生成的虚假照片,但照片刚开始被热传时,国内外社交平台上都有不少人信以为真。而后来出现的「甘肃火车事故」「八角大楼被袭」假新闻,也一次又一次挑起了人们的神经。

过去半年我们已经知道,ChatGPT 等生成式 AI 会不顾真假,生成海量似是而非的内容。而由 AI 生成的虚假内容又会被其他 AI 拿来学习后,再生成更加以假乱真的内容。甚至,AI 还可以根据用户的个人喜好一对一地生成虚假信息。因为 AI 可以扩大和再生产假新闻,未来可能造成更加严重的舆论造假。

更大的问题是,如果未来互联网甚至是真实世界都充斥着各种 AI 生成的虚假内容,一切都会崩溃。而从文字到图片再到声音,今天 AI 生成的内容与真人创作的内容之间变得越来越难以分辨,就像大部分人已经无法分辨 AI 孙燕姿、AI Drake 与真人声音。

同时 AI 的进化速度也太快了。几个月前我们可能还在说 AI 绘画「不会画手」,但等到 Midjourney V5 新版本推出之后,AI 不仅在「画手」上越发娴熟,各种细节也变得更逼真。在针对 AI 歌手的回应中,孙燕姿也看到了这一点:

「你可能会反对,说我还是能分辨出区别的,它没有情绪,没有音调和呼吸的变化。很抱歉,我怀疑这只是一个非常短期内的回应。」

图/孙燕姿

所以问题已经不在于我们能不能分辨 AI 生成的内容,而是我们应该如何辨认出 AI 生成的内容。

用「魔法」打败「魔法」?

人工识别首先就不现实,先不说人工分辨 AI 生成内容的准确性,我们还需要投入海量的人力。

去年年底 ChatGPT 发布之后,很多人就用它来生成论文,并取得了很好的成绩,同时也吸引了更多的学生效仿。随后,巴黎政治学院在内的一些全球知名学府纷纷出台了 ChatGPT 禁令。但据在线课程供应商 Study.com 此前发起的一项调查显示,1000 名 18 岁以上的学生中,超过 89%的学生都在使用 ChatGPT 来完成家庭作业。

但这个问题总要解决,而最好的办法,可能还是用「魔法」打败「魔法」?

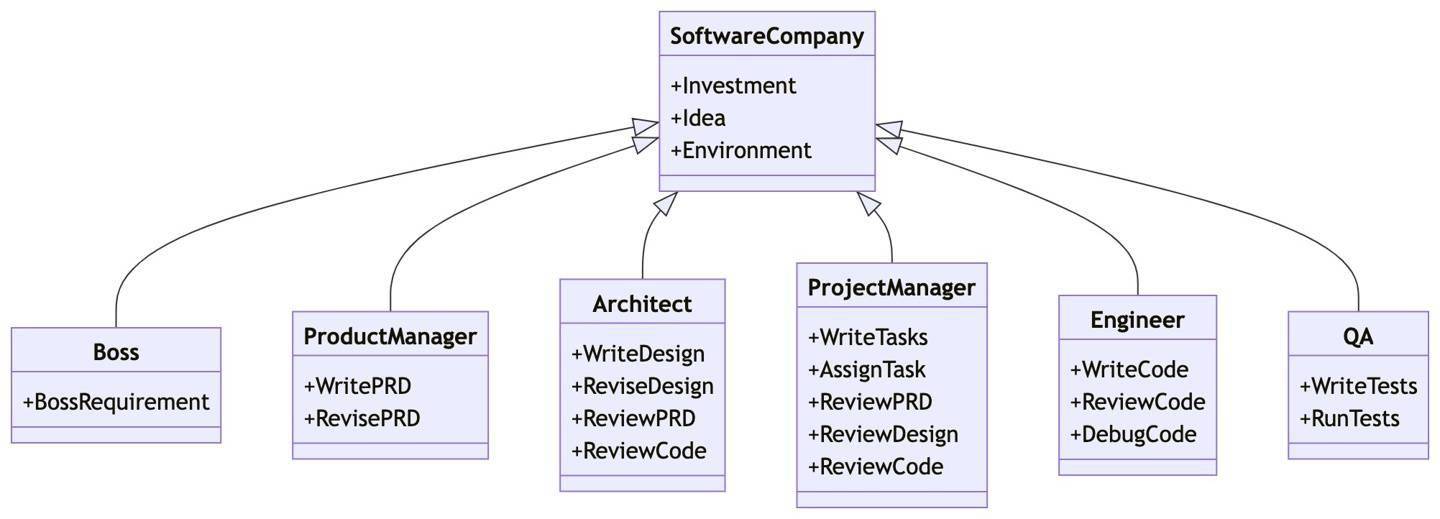

众所周知,一个社区的核心是用户与用户之间的交流,而 AI 生成的虚假内容一旦泛滥很容易摧毁这种交流,这也是所有在线社区极力避免的。但方法呢?除了依靠个人去辨别,很多时候我们又必须依赖 AI,比如前文提到 V2ex,其站长@Livid 为了分辨 AI 生成的灌水内容,就会直接反过来询问 AI「是否由 AI 生成」,以此作为是否封禁用户的依据。

图/V2ex

问题是这种方法还是存在太多的不确定性。

就在 ChatGPT 刚推出的几天后,OpenAI 宣布联合哈佛大学等高校和机构一起打造了 AI 检测器——GPT-2 Output Detector(GPT-2 输出检测器)。顾名思义,GPT-2 Output Detector 是基于 GPT-2 模型微调输出的工具,对基于 GPT-3.5 的 ChatGPT 实际效果并不好。

于是今年 2 月 1 日,OpenAI 转头又推出「AI 生成内容识别器」,目的是识别文本由 AI 生成还是人类撰写,本质上是一个辨别真实内容和 AI 生成内容的分类器。不过,OpenAI 在博客中指出,该识别器对 AI 生成内容的检测成功率仅为 26%:

可能还不如网友瞎猜。

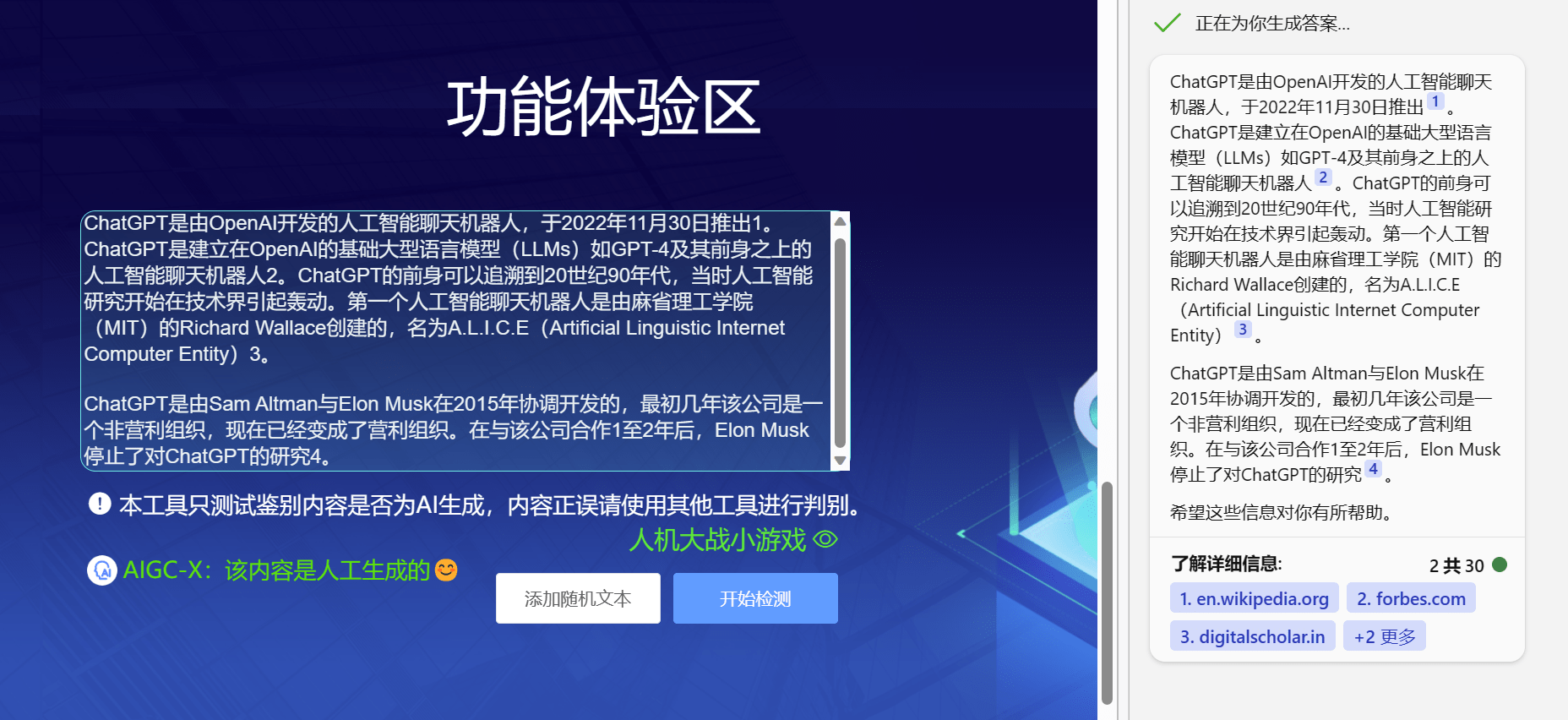

国内也出现了类似的 AIGC-X。这是一款由人民网下属传播内容认知国家重点实验室、中国科学技术大学、合肥综合性国家科学中心人工智能研究院联合推出的 AI 生成内容检测工具,支持对 AI 生成内容和人工生成内容的分辨。尽管有报道称 AIGC-X 对中文文本检测的准确率超过 90%,但实测并不如意。

即便有这么多错误,图/AIGC-X,Bing

可以说到目前为止,所有试图用 AI 打败 AI 的尝试都没有成功,本身这条路径也存在不少争议,有人就将其形容为新时代的「自相矛盾」——用最强的矛打最强的盾。

相比之下,「水印」成了越来越广泛的选择。5 月谷歌 I/O 大会上,谷歌率先宣布公司的每一张 AI 生成图片都会内嵌水印,水印无法肉眼识别,但可通过谷歌搜索引擎等软件读取并以标签显示出来,用以提醒用户该图片由 AI 生成。不久后,Shutterstock、Midjourney 等 AI 应用也宣布将支持这种新的标记方法。

但 AI 生成文字还在等待一个切实可行的方案。在 AI 生成内容识别器失败之后,OpenAI 也在考虑在生成的文本中加入数字水印,以降低模型被滥用带来的负面影响。OpenAI 对齐团队(主要负责系统安全性)负责人 Jan Leike 表示,OpenAI 已经探索在文本中加入水印。

不过,OpenAI CEO Sam Altman 在接受采访也提醒到,不存在一个完美的 AI 生成文字识别工具,原因是人们总会弄清楚他们要修改多少文字,还会出现修改输出文本的其他工具。

写在最后

之前在某个论坛上看到一个帖子,一位网友通过搜索引擎跳到知乎的一则回答,看到了一半才意识到这则回答大概是由 AI 生成,瞬间有种被喂 x 的感觉。

关键是如果主动使用 ChatGPT 之类的生成式 AI,我们可能对它的真实性、胡说八道都会有一定的预期,但显然我们无法阻止其他人使用并发布 AI 生成的虚假内容。打个比方,如果对历史并不熟悉的人,在知乎上看到一则言之凿凿讨论亚瑟王的回答,会不会误认为亚瑟王是真实存在的人物,甚至是一位女骑士(型月作品中的设定)。

但坦白讲,除了很明显的 AI 生成风格,我们很难在熟知领域之外分辨内容是否由 AI 生成,唯一能做的,可能就是更加审视我们所看到的内容。

题图来自《七宗罪》剧照