你知道什么是生成对抗网络吗

生成对抗网络(GANs)是一种深度学习模型,已经显示出在许多生成相关任务中的卓越性能。最近几年,越来越多的研究人员将注意力集中于 GAN 的隐空间属性,并提出了许多利用这些属性进行语义图像编辑的方法。然而,在传统的GANs方法中,由于对数据分布主体部分的拟合效果优先考虑,因此在数据集的分布边缘,GAN的生成效果会显著下降。这从根本上影响了利用GAN隐空间进行编辑的方法在数据集边缘处的表现。尤其对于需要编辑到边缘时的应用场景,例如人脸位姿编辑,这种问题更加突出。

在过去,为了增强 GAN 的生成效果,常见的方法是调整超参数或改变网络结构以适应不同的数据分布。但这种方法只能解决一部分问题,对于数据集的分布边缘仍然存在限制。最近,有越来越多的研究人员开始探索如何消除这个问题,以便更好地利用GAN的隐空间进行编辑。以下将介绍一些最近的进展和方法:

一种比较直接的方法是使用特定的损失函数来约束生成器的输出,并保证生成的图像在分布边缘仍然具有可接受的质量。例如,一种名为 Boundary Equilibrium Generative Adversarial.NETworks (BEGAN) 的方法已经提出,其通过在生成器和判别器之间引入平衡约束来实现对边缘数据的更好拟合效果。这种方法可以使得GAN生成的图像在边缘部分也能够获得高质量的表现。

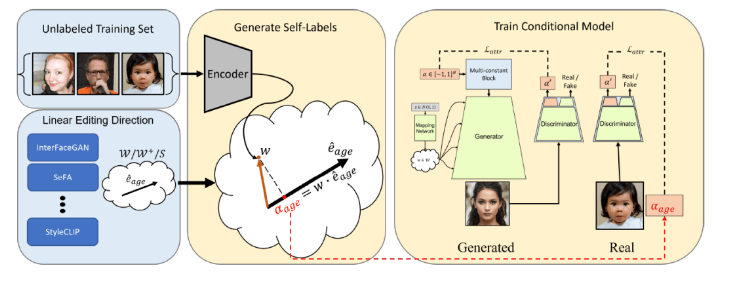

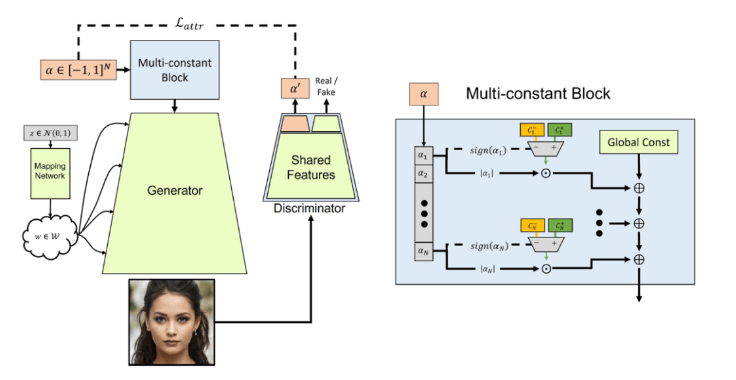

另一种方法是利用GAN的隐空间特性,设计更加复杂的网络结构和训练策略,并从隐空间角度去解决这个问题。一种名为StyleGAN2的技术已经被提出,可以根据输入图像的属性控制生成的图像属性(例如人脸的年龄、性别、面部表情等)。StyleGAN2不仅可以在主要分布区域产生高质量的图像,还可以在边缘分布处生成丰富多彩的图像,从而更好地满足了许多编辑需求。

除了上述方法,还有一些其他的技术也已经被提出,以缓解GAN在边缘数据上的限制。例如,在两个不同的 GANs 中交换生成器和判别器,以改善 GANs 在分布边缘的表现。又比如,通过引入噪声或自适应实例标准化的技术,可以增加数据分布中的多样性并提高 GANs 在边缘区域的表现。

随着对 GANs 的不断研究和改进,这个领域仍然存在许多挑战和机遇。尽管还有很多需要解决的问题,但我们相信 GANs 将会继续成为机器学习领域中一个重要的技术,并发挥越来越大的作用。在未来的研究中,我们期望可以更好地理解和应用 GANs,以创造更加逼真、多样和有用的生成数据,并推动相关领域的发展和进步。