你知道什么是大语言模型吗

在自然语言处理领域,大语言模型是一类十分重要的技术。顾名思义,大语言模型指的是比较“大”的(神经网络)语言模型,它们以自上文推理词语概率为核心任务。随着机器学习和深度学习技术的不断发展,人工智能的应用范围越来越广泛,而大语言模型则成为了自然语言处理、文本生成和对话系统等领域的重要组成部分。那么,你知道什么是大语言模型吗?

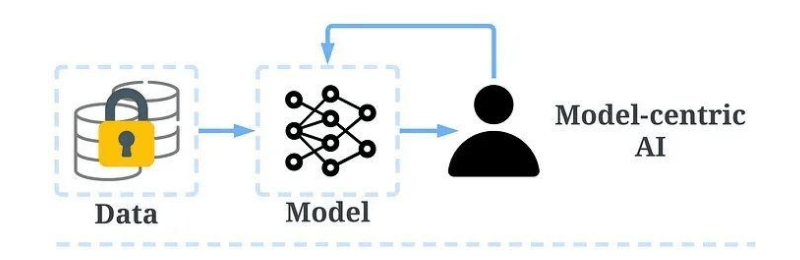

自然语言处理是人工智能领域的一个重要分支,它涉及了对自然语言的理解、生成和推断等任务。在这个领域中,大语言模型被认为是目前最先进的技术之一。它是一种基于神经网络的语言模型,可以根据上文预测下一个单词或短语的出现概率。这项技术需要大量的数据进行训练,以便从数据中学习到普遍的规律。

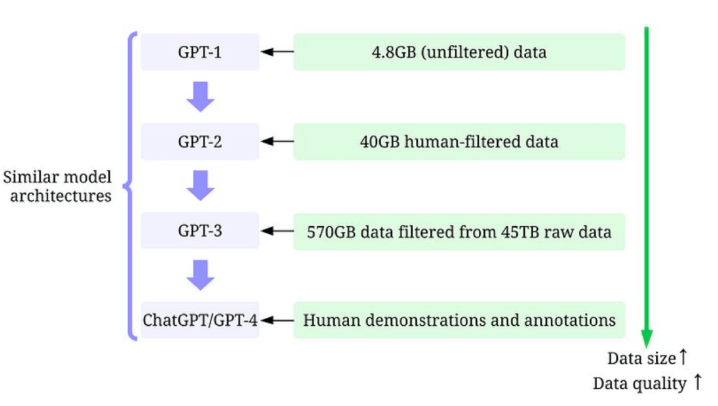

随着时间的推移,大语言模型不断发展壮大,并且各种改进版本相继问世。其中最为著名的是GPT(Generative Pre-trAIned Transformer)系列模型。这个系列的模型使用了Transformer架构,是一种基于注意力机制的神经网络架构,它在自然语言处理中表现出色。而GPT-1则是GPT系列模型的第一个版本,其结构主要由多层自回归式的Transformer组成。

GPT-1采用了预训练的方式进行学习,即在大规模语料库上进行训练。该模型的输入是文本序列,输出则是下一个单词或短语的概率分布。这些模型的优势在于可以利用海量的数据进行训练,从而学习到一些常见的语言规律和模式。此外,GPT-1还可以进行文本生成、分类和序列标注等任务,表现优异。

GPT系列模型的后续版本主要区别在于它们具有更多的参数。例如,GPT-2的参数数量是GPT-1的10倍,为1.5亿个。GPT-2采用了更多的自注意力头,使得模型能够学习到更加复杂的语言结构。同时,它还具有Zero-shot Learning和Few-Shot Learning技术,可以更好地适应新任务的执行和学习。

而GPT-3则是GPT系列模型的最大版本,其参数数量高达1750亿个。GPT-3不仅在文本生成方面表现出色,还可以进行问答、对话等更为复杂的任务。该模型拥有很强的适应性和灵活性,且能够从零样本或少样本学习中进行新任务的执行和学习。

总的来说,大语言模型的发展让自然语言处理领域取得了巨大的进展,使得我们可以更加高效地处理文本和自然语言相关的任务。随着技术的不断创新和突破,我们相信大语言模型将会在未来发挥出更加重要的作用。通过更好地研究和应用大语言模型,我们有望解决更多实际问题,使得机器学习和人工智能更加贴近现实生活,更好地服务于人类社会。