谷歌开源首个「方言」数据集:让机器翻译更地道

新智元报道

编辑:LRS

【新智元导读】数据集包含葡萄牙语和汉语普通话。

虽然全中国的人都在说汉语,但具体到各地的方言却略有不同,比如同样是 小巷的意思,「胡同」一开口就知道是老北京了,而到了南方则叫「弄」。

这种细微的 地域性差异反应在「机器翻译」任务上,就会显得翻译结果不够「地道」,而目前几乎所有的机器翻译系统都没有考虑地区性语言(即方言)的影响。

而在世界范围内也存在这种现象,比如巴西的官方语言是葡萄牙语,跟欧洲的葡萄牙语之间也有一些地域性差异。

最近谷歌发布了一个全新的,可用于Few-shot Region-aware机器翻译的数据集和评估基准FRMT,主要解决方言翻译问题,论文发表在TACL(Transactions of the Association for Computational Linguistics)上。

论文链接:https://arxiv.org/pdf/2210.00193.pdf

开源链接:https://Github.com/google-research/google-research/tree/master/frmt

该数据集包括从英语到葡萄牙语和中文普通话的两个地区变体的专业翻译,源文档是为了能够详细分析感兴趣的现象,包括词汇上不同的术语和干扰术语。

研究人员探索了 FRMT 的自动评估指标,并在区域匹配和不匹配评分情景下验证了其与专家人工评估的相关性。

最后,为这项任务提出了一些基线模型,并为研究人员如何训练、评估和比较自己的模型提供指导建议,数据集和评估代码已开源。

Few-Shot泛化

大多数现代机器翻译系统都经过数百万或数十亿翻译样本的训练,输入数据包括英语输入句及其相应的葡萄牙语翻译。

然而,绝大多数可用的训练数据并没有说明翻译的地区差异。

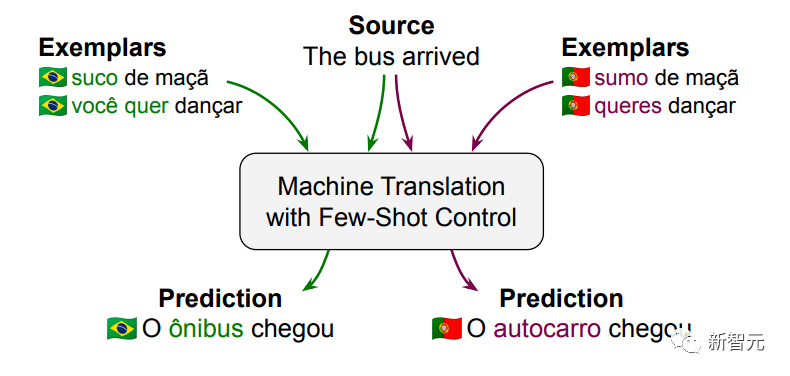

比如输入句子:The bus arrived,再给定几个巴西葡萄牙语的例子,模型应该能翻译出「O ônibus chegou」;如果给的样例是欧洲葡萄牙语,模型的翻译结果应该变为「O autocarro chegou」。

机器翻译的few-shot方法是很有研究价值的,能够以一种非常简单的方式来对现有系统中增加对额外区域语言的支持能力。

虽然谷歌目前发表的工作是针对两种语言的区域变体,但研究人员预测,一个好的方法将很容易适用于其他语言和区域的变体。

从原理上来说,这些方法也适用于其他语言差异现象,例如礼节和风格等。

数据收集

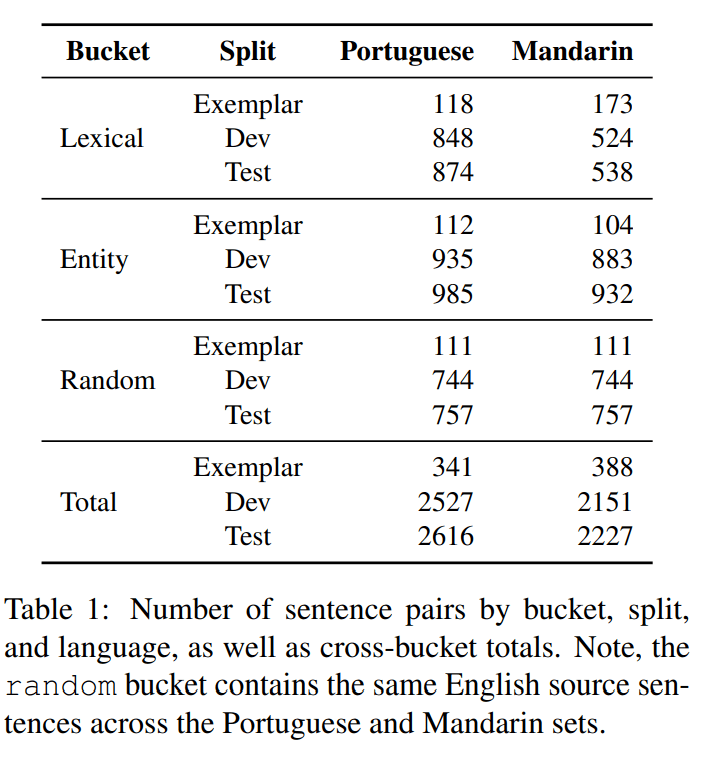

FRMT 数据集包括部分英文维基百科文章,来源于 Wiki40b 数据集,这些文章已经由付费的专业翻译人员翻译成不同的地区性的葡萄牙语和汉语。

为了突出关键区域感知的翻译难题,研究人员使用了三个内容桶(content buckets)来设计数据集:

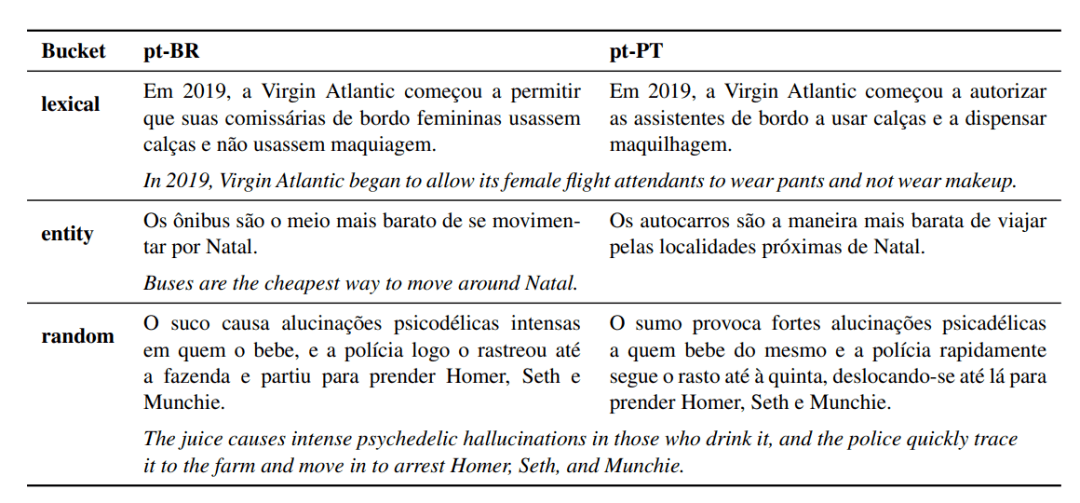

1. 词汇 Lixical

研究人员根据博客和教育网站手动收集了20-30个具有地区特色的翻译术语,并根据来自每个地区的母语志愿者的反馈对翻译进行过滤和审核。

根据得到的英语术语列表,从相关的英语维基百科文章(例如,bus)中提取出100个句子。再对普通话,重复上述相同的的收集过程。

2. 实体 Entity

实体桶以类似的方式填充,涉及的人、位置或其他实体与某一特定语言所涉两个区域之一有着密切联系。

比如给定一个说明性的句子,如「In Lisbon, I often took the bus.」(在里斯本,我经常坐公共汽车。),为了正确地将其翻译成巴西葡萄牙语,模式必须能够识别出两个潜在的陷阱:

1)里斯本和葡萄牙之间更密切的地理关联可能会影响模型翻译的选择,从而帮助模型判断出应该翻译成欧洲葡萄牙语而非巴西葡萄牙语,即选择「autocarro」而不是「ônibus」。

2)用「巴西利亚」代替「里斯本」可能是一个比较简单的方式,对于同一个模式,对巴西葡萄牙语本地化其输出,即便翻译结果仍然很流畅,但也可能会导致不准确的语义。

3. 随机 Random

随机桶用于检查一个模型是否正确处理了其他不同的现象,包含从维基百科的featured和good)集合中随机抽取的100篇文章。

系统性能

为了验证为 FRMT 数据集收集的翻译能够捕获特定区域的现象,研究人员对数据质量进行了人工评估。

对于每个地区,研究人员要求 MQM 评分者对来自他们所在地区的翻译和来自他们语言的其他地区的翻译进行评分。

例如,巴西的葡萄牙语评分员同时对巴西和欧洲的葡萄牙语译本都进行了评分,两个分数之间的差异表明语言现象的普遍性,即该语言变体是否可接受,而并非是另一种语言。

实验结果发现,在葡萄牙语和汉语中,评分者平均比匹配的译文中每个句子多发现大约两个主要错误,表明FRMT数据集确实能够捕获特定区域的语言现象。

虽然人工评估是确保模型质量的最佳方法,但其往往是缓慢且昂贵的。

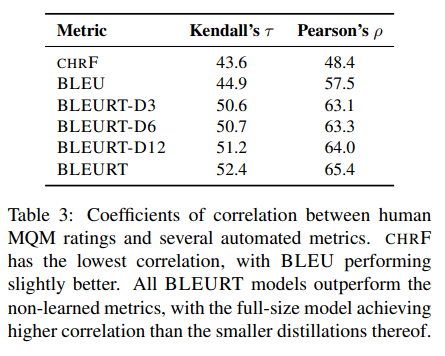

因此,研究人员希望找到一个现成的自动度量指标,可以用来评估模型在基准中的性能,研究人员考虑选择使用 chrF,BLEU 和 BLEURT.

根据 MQM 评估者对几个基线模型翻译结果的评分,可以发现 BLEURT 与人类判断具有最好的相关性,并且该相关性的强度(0.65 Pearson 相关系数,ρ)与标注者间一致性(0.70组内相关性)相当。

系统性能

文中评估了一些最近发布的、具有few-shot控制能力的模型。

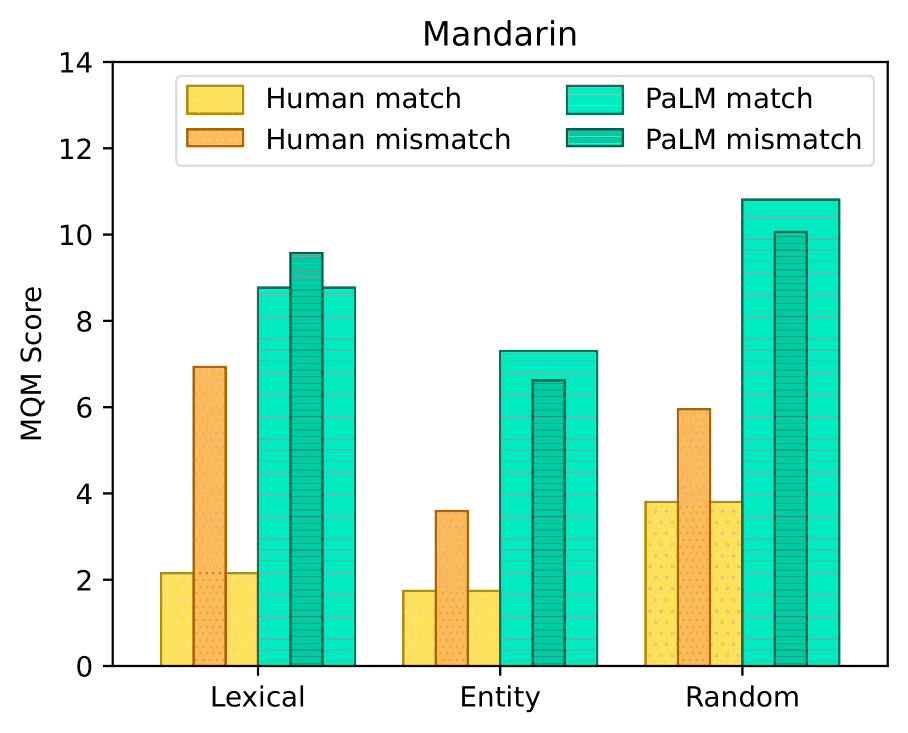

基于 MQM 的人类评估,基线方法都表现出一定的localize葡萄牙语输出的能力,但是对于中文普通话,大多没有利用目标地区的知识来生成优秀的当地翻译结果。

在评估的基准中,谷歌的语言模型 PaLM 模型的性能最佳,为了使用 PaLM 生成针对区域的翻译,首先将一个有指导意义的提示输入模型,然后从中生成文本以填充空白。

PaLM 仅通过一个例子就获得了很好的结果,在葡萄牙语方面,当增加到10个例子时,质量略有提高,考虑到 PaLM 是在无监督的情况下进行训练的,这种表现已经非常好了。

研究结果还表明,像 PaLM 这样的语言模型可能特别擅长记忆流畅翻译所需的特定区域的词汇选择。

然而,在 PaLM 和人类之间仍然存在显著的性能差距。

参考资料:

https://ai.googleblog.com/2023/02/frmt-benchmark-for-few-shot-region.html