今天聊聊基于Transformer结构的视觉领域模型ViT

近年来,随着深度学习技术的迅猛发展,图像处理一直是人工智能领域的重要研究方向。传统的卷积神经网络(CNNs)在视觉任务上取得了巨大成功,但它们对于长距离依赖关系的建模存在一定限制。然而,最近提出的ViT(Vision Transformer)模型以其基于Transformer结构的创新设计,引起了广泛关注。本文将介绍什么是ViT,以及它如何改变了图像处理和计算机视觉领域。

一、什么是ViT?

ViT是一种基于Transformer结构的视觉领域模型。Transformer最初是为自然语言处理任务设计的,但其强大的序列建模能力激发了研究人员将其应用于图像处理领域。ViT通过将图像分割成小的图块,并使用Transformer编码器来处理这些图块,从而实现了对图像的建模和理解。

二、ViT的工作原理:

图像分割:ViT将输入的图像分割成固定大小的图块,每个图块都被认为是一个输入令牌。

位置编码:为了引入图像中的位置信息,ViT在输入令牌中引入了位置编码。位置编码通过学习和表示每个图块在原始图像中的相对位置关系。

Transformer编码器:ViT使用多层Transformer编码器来对图块进行特征提取和建模。这些编码器将图块序列作为输入,并通过自注意力机制和前向神经网络来捕获全局和局部间的关联性。

分类头部:ViT通过一个线性分类层来预测图像的标签或执行其他任务,如目标检测或图像分割。

三、ViT的优势和应用:

长距离依赖性建模:传统CNNs在处理长距离依赖关系时存在限制,而ViT通过Transformer结构有效地建模了图像中的全局依赖关系,对长距离信息的建模能力得到显著提升。

可解释性和可迁移性:ViT通过自注意力机制使得模型能够关注图像中不同图块之间的重要关系,提高了模型的可解释性。此外,ViT在训练过程中没有利用任何与图像内容相关的先验知识,因此具有良好的可迁移性,适用于多种视觉任务。

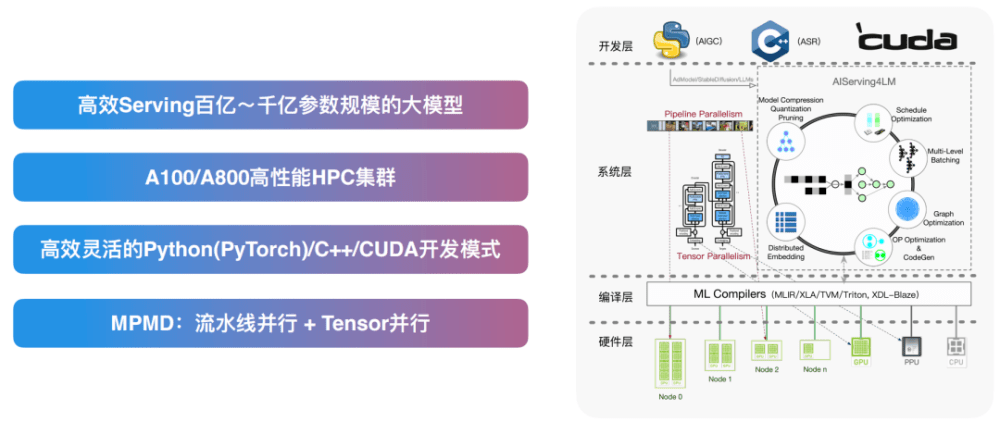

模型压缩和并行计算:由于ViT的自注意力机制在不同图块之间进行独立计算,因此可以实现高效的并行计算。这也使得ViT在模型压缩方面具有潜力,能够更好地适应资源受限的环境。

四、挑战与未来发展:

尽管ViT在图像处理领域取得了令人瞩目的成果,但仍面临一些挑战。其中之一是对大尺度图像的处理问题,由于内存和计算资源的限制,ViT对于高分辨率图像的处理仍存在困难。此外,ViT的训练过程相对于传统CNNs较为耗时,需要进一步的研究和改进。

未来,ViT的发展方向包括以下几个方面:

改进模型结构:研究人员正在探索如何改进ViT的模型结构,以提高其性能和效率。例如,引入多尺度处理机制,使ViT能够更好地处理不同尺度的特征;使用注意力机制来加强对关键图块的关注等。

模型压缩和优化:由于ViT的模型规模较大,模型压缩和优化是一个重要的研究方向。通过剪枝、量化和蒸馏等技术,可以减少模型的存储空间和计算需求,提高其在资源受限环境下的应用性能。

预训练与迁移学习:预训练在深度学习中发挥着重要作用,ViT也可以从大规模数据集中进行预训练,以提取丰富的特征表示。此外,探索如何将ViT的知识迁移到其他任务和领域,进行迁移学习和领域自适应,将是未来的研究方向。

结合其他视觉任务:除了图像分类,ViT在目标检测、语义分割、图像生成等任务上的应用也值得进一步研究。结合ViT的优势,探索如何将其应用于多个视觉任务,并取得更好的性能和效果。

综上所述,ViT作为一种基于Transformer结构的视觉领域模型,通过创新地将自注意力机制引入图像处理中,突破了传统卷积神经网络的限制,实现了对长距离依赖关系的建模。它具备可解释性、可迁移性以及模型压缩和并行计算等优势,并在图像分类等任务上取得了显著成就。然而,ViT仍面临着挑战,如对大尺度图像的处理和模型训练的耗时等。未来的发展方向包括改进模型结构、模型压缩和优化、预训练与迁移学习以及结合其他视觉任务等。随着技术的不断进步和研究的深入,ViT有望在计算机视觉领域带来更多的突破和应用。